Qualche giorno fa ho pubblicato il terzo e, speravo, ultimo articolo di un reportage sui cambiamenti climatici. In questo articolo, intitolato “I cambiamenti climatici? Sì, siamo noi i responsabili”, ho discusso delle prove oggettive – corredate da riferimenti puntuali – che hanno portato l’intera comunità scientifica alla conclusione che i responsabili di quanto sta accadendo attualmente sulla superficie terrestre, ovvero l’aumento delle temperature globali e la conseguente alterazione degli ecosistemi, siamo noi esseri umani.

In quel testo ho cercato di mostrare, in modo accessibile ma rigoroso, perché la tesi dell’origine antropica dell’attuale riscaldamento globale non sia più un’ipotesi, ma una conclusione supportata da una mole imponente di dati.

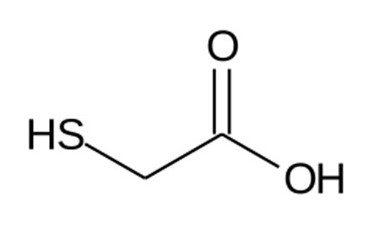

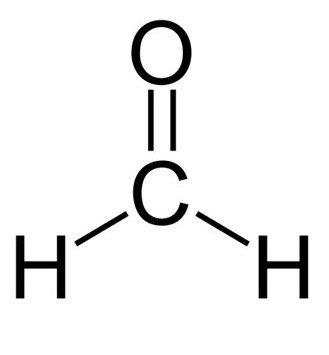

Ho parlato del ruolo dei gas serra, in particolare della CO₂ prodotta dalla combustione di combustibili fossili, la cui impronta isotopica è ben riconoscibile in atmosfera. Ho discusso anche delle fonti indipendenti che confermano il trend in atto – dalle carote glaciali agli anelli degli alberi, dai sedimenti oceanici alle misurazioni satellitari – e delle ragioni per cui né l’attività solare né le eruzioni vulcaniche possono spiegare ciò che osserviamo oggi.

Infine, ho evidenziato come la rapidità del riscaldamento attuale – oltre un grado in appena un secolo – sia senza precedenti nella storia recente del pianeta, e come l’intero corpo scientifico internazionale, sintetizzato nei report dell’IPCC, abbia ormai raggiunto un consenso solido e ben documentato su questo punto.

Non è necessario riproporre qui tutti i riferimenti bibliografici: si trovano nell’articolo appena riassunto (qui il link).

Eppure, eccomi di nuovo a scrivere sull’apporto antropico all’effetto serra. Non per aggiungere nuove evidenze, ma per riflettere sul modo estremamente fallace – e sempre più diffuso – di ragionare dei negazionisti del cambiamento climatico. Non si tratta, in questo caso, di negazionisti tout court: anche loro, ormai, devono riconoscere l’evidenza dell’aumento delle temperature globali. Si tratta piuttosto dei negazionisti dell’origine antropica, coloro che rifiutano di accettare che la causa principale del riscaldamento sia l’attività umana.

In un gruppo Facebook che aiuto a gestire – Bufale e dintorni gruppo – sono comparsi i primi commenti al mio post con cui pubblicizzavo l’articolo (potete farvene un’idea a questo link).

Poiché si tratta di un gruppo privato – quindi i post non sono visibili pubblicamente – e considerando che non tutti hanno un account Facebook attivo, riporto di seguito gli screenshot della discussione.

La Figura 1 riporta la condivisione dalla mia pagina Facebook “Rino Conte”.

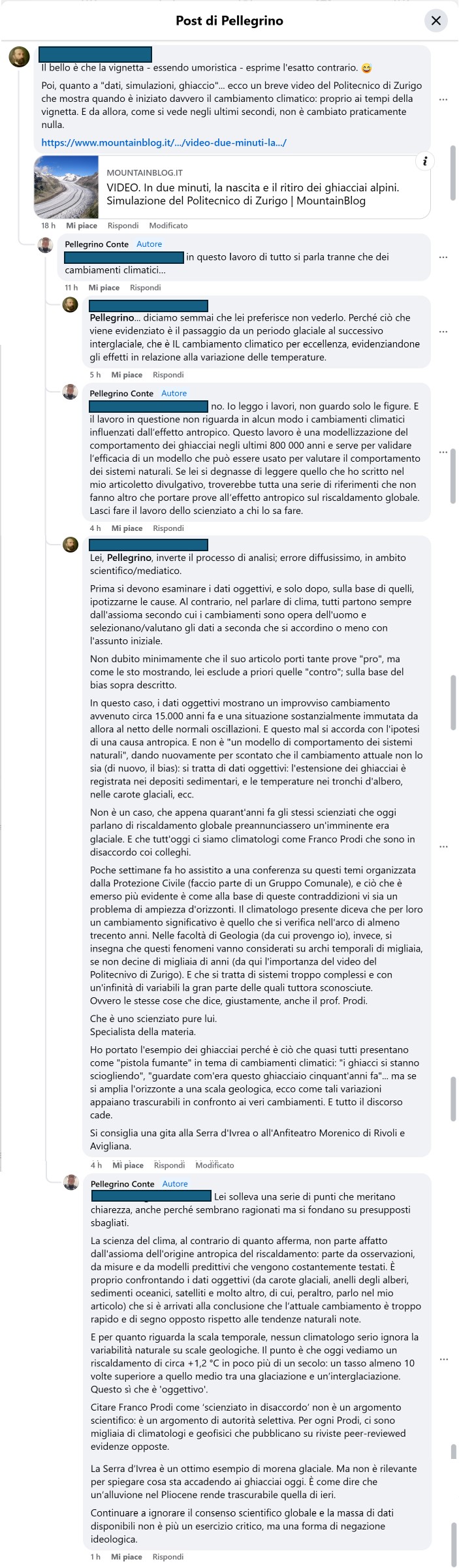

La Figura 2 riporta (spero in modo leggibile, altrimenti è necessario da parte dei volenterosi scaricare l’immagine ed effettuarne uno zoom) la discussione in corso tra me ed il negazionista dell’effetto antropico sul clima.

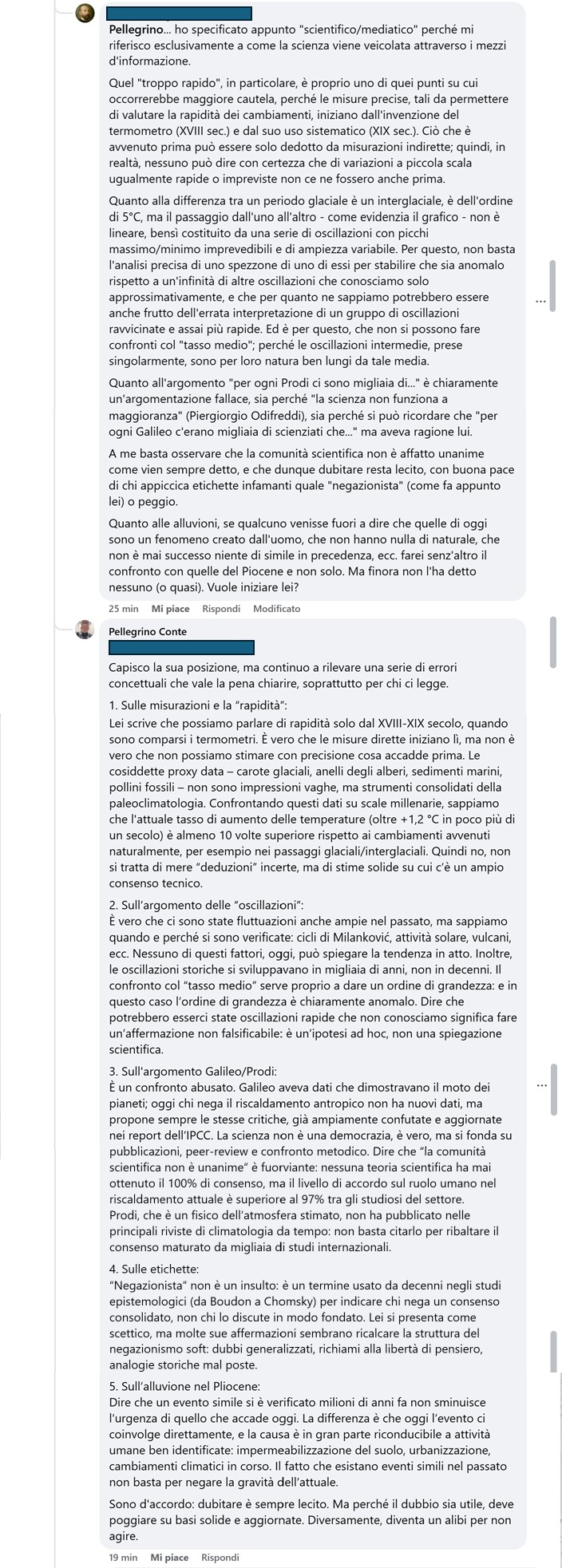

E proprio mentre sto scrivendo questo articolo la discussione continua (Figura 3).

Come si evince dagli screenshot, il tutto ha inizio dall’inserimento di un link a un articolo giornalistico in cui si riporta un filmato che mostra il comportamento di certi ghiacciai negli ultimi 800 000 anni. Questo filmato è tratto da un lavoro scientifico dal titolo “Modelling last glacial cycle ice dynamics in the Alps” pubblicato nel 2018 sulla rivista The Cryosphere della European Geoscience Union, associazione per la quale anche io ho organizzato in passato dei miniconvegni nell’ambito delle attività congressuali più generali che si fanno ogni anno a Vienna in Austria (per esempio, uno è qui).

Chi ha condiviso questo studio nella discussione lo ha fatto con l’intento – più o meno esplicito – di suggerire che, dal momento che i ghiacciai alpini si sono espansi e ritirati ciclicamente nel passato, il cambiamento climatico attuale potrebbe essere semplicemente parte di una lunga variabilità naturale. È un’inferenza del tutto errata, che nasce da un fraintendimento delle finalità e dei contenuti del lavoro scientifico citato.

Infatti, lo studio in questione (Seguinot et al., 2018) non parla di cambiamenti climatici attuali né tantomeno ne discute le cause. Si tratta di un lavoro di modellizzazione numerica della dinamica glaciale delle Alpi durante l’ultimo ciclo glaciale (da 120.000 a 0 anni fa), che ha lo scopo di testare la coerenza tra ricostruzioni geologiche e simulazioni del comportamento dei ghiacciai su scala millenaria. Non c’è nel testo alcuna analisi delle cause del riscaldamento moderno, né alcun confronto con l’evoluzione recente del clima terrestre.

Quello che il mio interlocutore ha fatto è un tipico esempio di bias di conferma: ha estrapolato da un articolo tecnico una conclusione che non c’è, perché questa coincide con la propria convinzione preesistente. È un meccanismo comune tra i cosiddetti “negazionisti soft” – persone che, pur riconoscendo che il clima sta cambiando, rifiutano l’idea che l’essere umano ne sia il principale responsabile.

La dinamica della discussione su Facebook lo conferma: ogni volta che si porta un dato, una misura, una ricostruzione paleoclimatica, l’interlocutore non contesta la validità della fonte, ma sposta il piano, relativizza, introduce “dubbi” storici o filosofici. E infine si rifugia nel mito del “Galileo solitario”, come se ogni minoranza fosse destinata a diventare verità solo perché è minoranza. Ma Galileo non aveva ragione perché era solo: aveva ragione perché aveva i dati e un metodo.

Ecco il punto: il problema non è tanto avere un’opinione diversa, quanto non saper distinguere tra opinione personale e conoscenza scientifica. E non è un caso che questo tipo di retorica si ritrovi spesso in altri ambiti della disinformazione scientifica: chi si sente “eretico” rispetto al sapere ufficiale tende a sopravvalutare le proprie intuizioni e a sottovalutare il lavoro, faticoso e rigoroso, di chi fa scienza sul serio.

Discutere con chi rifiuta le conclusioni della scienza può essere faticoso, ma è anche necessario. Non per convincere chi ha già deciso di non ascoltare, ma per fornire strumenti a chi legge in silenzio, a chi cerca chiarezza in mezzo al rumore. La scienza non ha bisogno di essere difesa come un dogma: si difende da sé, con i dati, con la trasparenza dei metodi, con la disponibilità al confronto critico. Ma proprio per questo va protetta dalle distorsioni, dalle semplificazioni, e soprattutto dal relativismo delle opinioni travestite da verità.

Il cambiamento climatico attuale è un fenomeno reale, misurabile e in larga parte causato dalle attività umane. Continuare a negarlo non è esercizio di pensiero critico, ma una forma di resistenza ideologica che rischia di ritardare l’unica cosa che oggi dovremmo fare: affrontare il problema con serietà, competenza e senso di responsabilità.

EDIT

Mentre mi accingevo a pubblicare questo articolo, il mio interlocutore ha pubblicato un’ultima risposta che ho deciso di riportare integralmente per completezza. Qui sotto trovate anche la mia replica con cui ho deciso di concludere la discussione pubblica.

Interlocutore:

Pellegrino…

- Lei stesso parla di “stime solide”; che sono appunto stime, non misurazioni dirette.

- “Sappiamo perché”, è un’altra forzatura. In realtà abbiamo delle interpretazioni plausibili per molte di esse, ma ciò non equivale a una certezza assoluta. Anche nelle osservazioni attuali, ci si imbatte in anomalie impreviste, tipo l’impatto dello scioglimento del permafrost, temperature previste che poi non si sono verificate… E parliamo di osservazioni dirette; figuriamoci sulle “stime” di fenomeni non osservati direttamente. Per non parlare dell’infinito dibattito su quanto influiscano o meno le macchie solari…

Stesso discorso sul fatto che le oscillazioni in passato non avvenissero in decenni, trascurando che non possiamo sapere se gli strumenti che abbiamo a disposizione siano davvero affidabili con tale precisione. Mancando l’osservazione diretta, non possiamo verificarlo.

Dire che “potrebbero esserci state” significa semplicemente dire che il modello generale è ancora soddisfatto; per dimostrare l’anomalia bisogna dimostrare che davvero non ci siano precedenti. È un discorso di presunzione d’innocenza: per dare la colpa all’uomo bisogna dimostrarla; il “ragionevole dubbio” è a favore dell’imputato. Foss’anche solo per mancanza di prove.

- Il moto dei pianeti era noto da sempre (“planities” significa appunto “errante”), ma lui (anzi, Copernico) fornì solo un modello di calcolo semplificato. Infatti, a dirla tutta, il sole non è affatto al centro dell’universo ma si muove pure lui… In questo ha ragione l’insegnante del prof. Barbero che diceva che il card. Bellarmino era più moderno di Galileo.

- A “negazionista” si potrebbe contrapporre “fideista”, ovvero uno che sposa senz’altro ciò che dice la maggioranza stigmatizzando il dubbio. Ma io continio a ricordare che la stessa comunità scientifica oggi certa del riscaldamento globale appena quarant’anni fa era ugualmente certa dell’imminenza di un’era glaciale. Un cambio di rotta di 180 gradi in meno di mezzo secolo, e si dovrebbe prendere per oro colato anche l’attribuzione di responsabilità? Anche a fronte di numerose previsioni rivelatesi poi errate?

- Su un punto, concordo senz’altro: sulla separazione netta tra dissertazione scientifica e azione concreta (e non potrei dire diversamente, dato che come ho già detto opero nella Protezione Civile).

Il punto certo è che vi sia in atto un cambiamento climatico che attualmente va verso un aumento delle temperature, che il problema è serio e che la cosa va affrontata. Ridurre il più possibile (e possibilmente azzerare) l’impatto antropico non ha controindicazioni, e quindi va benissimo farlo; e infatti ne sono da sempre un convinto sostenitore.

A mio modesto parere, non servirà a granché, perché se Madre Natura ha deciso che è tempo di un nuovo Eocene, Eocene sarà; che ci piaccia o no.

Quindi, oltre ad azzerare le emissioni, miglioriamo l’efficienza dei condizionatori, perché ne avremo comunque bisogno. Tutto qui.

Io:

grazie per aver chiarito ulteriormente il suo punto di vista. Le rispondo un’ultima volta, per chi ci legge e non per la soddisfazione di “avere l’ultima parola”, che non mi interessa.

Sì, le proxy sono stime, ma sono stime calibrate, validate e incrociate da molte fonti indipendenti. Nessun climatologo confonde una proxy con una misura diretta, ma la scienza lavora ogni giorno per rendere sempre più affidabili quelle stime. E il fatto che convergano tutte sul medesimo trend dà forza alla ricostruzione. Questo è il normale funzionamento della scienza, non una debolezza.

Nessuno pretende certezze assolute, né le scienze naturali le promettono. Lei invece sembra richiedere una prova “oltre ogni dubbio”, come se fossimo in un’aula di tribunale. Ma la scienza si basa sulla probabilità, sul peso delle evidenze, sulla capacità predittiva dei modelli. Oggi, la quantità di prove che puntano all’origine antropica del riscaldamento è così ampia da rendere l’ipotesi alternativa – quella esclusivamente naturale – altamente improbabile. Ed è su questo che si fondano le politiche, non sull’attesa della perfezione epistemologica.

Il paragone con Galileo e Bellarmino è affascinante ma fuori luogo. Galileo non aveva solo un modello “più semplice”: aveva anche l’evidenza delle fasi di Venere e delle lune di Giove. Il suo valore non sta nel ribellarsi alla maggioranza, ma nell’aver offerto dati e osservazioni migliori. Lei invece continua a proporre “dubbi” senza portare nessun dato nuovo, solo generalizzazioni.

La comunità scientifica non era “certa” dell’era glaciale negli anni ’70. Questa è una leggenda urbana, smentita dai dati storici: all’epoca la maggior parte degli articoli già indicava un riscaldamento, non un raffreddamento. Se guarda i paper dell’epoca, lo vede chiaramente.

Quanto agli errori previsionali: il fatto che un modello venga corretto o raffinato è normale in ogni scienza. Non è un fallimento, è progresso. Non confondiamo fallibilità con inattendibilità.

Mi fa piacere leggere che riconosce l’urgenza del problema e sostiene l’azione per ridurre le emissioni. Su questo ci troviamo d’accordo. Tuttavia, dire “tanto non servirà a nulla” è una rinuncia mascherata da fatalismo. La scienza climatica non dice che siamo condannati, ma che abbiamo una finestra temporale per ridurre gli impatti futuri. La differenza tra +1,5 °C e +4 °C non è affatto irrilevante. E anche se non possiamo evitare ogni effetto, possiamo evitare quelli peggiori. Questa è responsabilità, non fideismo.

Chiudo qui il mio intervento, perché i fatti, i dati e il consenso scientifico sono pubblici e verificabili. Il resto è opinione personale – legittima – ma non equiparabile alla conoscenza prodotta dalla scienza.

Nota finale: ho riportato per esteso questo scambio non per dare visibilità a una posizione pseudoscientifica, ma per mostrare, in modo documentato, come ragiona chi nega l’origine antropica del cambiamento climatico, e perché queste argomentazioni non reggano al vaglio della scienza.

[Scena: in una loggia, i tre siedono a discorrere. Il sole volge al tramonto.]

[Scena: in una loggia, i tre siedono a discorrere. Il sole volge al tramonto.]