Qualche settimana fa ho dedicato una nota dal titolo “Omeopatia e fantasia” (clicca qui) ai risultati di Benveniste e Montagnier in merito ad uno dei cavalli di battaglia più incisivi di quelli che io definisco gli “amici dell’omeopatia”, ovvero la memoria dell’acqua. Ho messo in evidenza come il lavoro di Benveniste sia stato smentito dagli editor di Nature (rivista su cui il concetto di memoria dell’acqua fu pubblicato per la prima volta nel 1988) così come il lavoro di Montagnier sia risultato affetto da limiti sperimentali che hanno reso le conclusioni ivi contenute del tutto inaffidabili.

Tuttavia ho anche concluso che una anomalia chimica come la memoria dell’acqua non è passata inosservata e, dopo le pubblicazioni di Benveniste e Montagnier – nonostante tutti i limiti di cui ho discusso, il mondo scientifico non se ne è stato con le mani in mano.

Tutti noi lavoriamo per scrivere i nostri nomi nei libri di storia della scienza. Se “annusiamo l’affare”, ci buttiamo a pesce per essere tra i primi, se non i primi, a descrivere il modello più adatto per spiegare certi fenomeni strani. La conseguenza è che la letteratura è piena di studi i cui autori descrivono i loro infruttuosi tentativi di trovare la “pietra filosofale”. E’ quanto accaduto anche per la memoria dell’acqua. Ma andiamo con ordine ed applichiamo il metodo scientifico di cui ho già scritto qui, qui e qui.

La domanda

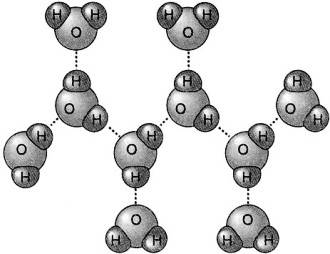

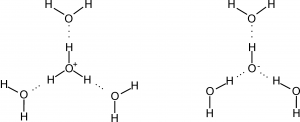

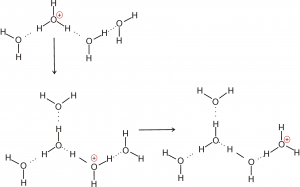

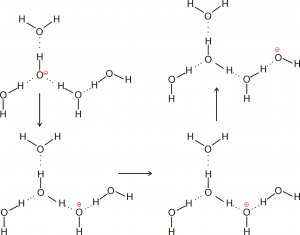

Alla luce dei risultati di Benveniste, immaginiamo che un principio attivo lasci la sua impronta all’interno del solvente che lo contiene e che tale impronta permanga nel sistema dopo una sequenza di succussioni e diluizioni successive. Questa impronta deve essere fatta da molecole di acqua che si muovono a velocità differenti, ovvero ci si deve aspettare che le molecole di acqua sui bordi dell’impronta debbano essere meno mobili di quelle più lontane dall’impronta.

Supponiamo ora che sia valido quanto affermato da Montagnier in merito alla presenza di nano-strutture di acqua tenute assieme da radiazioni elettromagnetiche. Ci dovremmo aspettare anche in questo caso la presenza di acqua che si muove a differenti velocità. Infatti le molecole di acqua impegnate nella formazione di nano-strutture, trovandosi in domini chimici piuttosto ingombranti rispetto alle dimensioni di una singola molecola di acqua, si devono muovere più lentamente di quelle che sono posizionate in zone più lontane dalle predette nano-strutture.

E’ possibile trovare delle evidenze sperimentali che possano validare le ipotesi suddette formulate sulla base di studi ritenuti in ogni caso inaffidabili dalla comunità scientifica?

Gli esperimenti in risonanza magnetica nucleare

La risonanza magnetica nucleare (NMR) permette di studiare il comportamento della materia in presenza di campi magnetici ad intensità differente. Non è questa la sede per entrare nei dettagli della tecnica che possono essere trovati altrove [1].

In modo molto semplicistico possiamo dire che al variare dell’intensità del campo magnetico è possibile misurare la velocità con cui si muovono le molecole di acqua confinate in specifici intorni chimici. In particolare, per intensità basse del campo magnetico applicato, si possono monitorare le velocità di molecole di acqua che si muovono lentamente. Man mano che aumenta l’intensità del campo magnetico applicato si può monitorare la velocità di molecole di acqua che si muovono con velocità progressivamente più elevata.

Nel 1999, Rolland Conte et al. [2] pubblicano una “Theory of high dilutions and experimental aspects” dove vengono riportati dati sperimentali a supporto di una teoria delle “impronte” che sembra validare la presunta efficacia dell’omeopatia. Tuttavia, le evidenze sperimentali riportate in quel libro sono state completamente smentite dai lavori di Milgrom et al. [3] e Demangeat et al. [4]. Questi autori, infatti, hanno evidenziato, mediante applicazione della tecnica NMR, che i risultati di Rolland Conte e collaboratori sono ascrivibili ad artefatti derivanti da impurezze rilasciate dalle pareti dei recipienti di vetro usati per gli esperimenti. Nessuna “impronta” rilasciata dal soluto nel solvente e presente anche dopo un certo numero di diluizioni e succussioni, è stata rilevata da Aabel et al. [5] che scrivono:

“there is no experimental evidence that homeopathic remedies make any kind of imprint on their solvent, which can be detected with nuclear magnetic resonance”.

Alle stesse conclusioni giunge anche Anick [6] che riporta:

“no discrete signals suggesting a difference between remedies and controls were seen, via high sensitivity 1H-NMR spectroscopy. The results failed to support a hypothesis that remedies made in water contain long-lived non-dynamic alterations of the H-bonding pattern of the solvent”.

Le evidenze di Milgrom et al., Demangeat et al., Aabel et al. e Anick, sono state recentemente confermate anche da Baumgartner et al. [7] che riportano:

“No clear pattern emerged with respect to a difference between homeopathic preparations and controls or between homeopathic preparations”.

Da quanto appena riportato, si comprende che l’ipotesi sulla memoria dell’acqua è stata falsificata in senso popperiano. In altre parole l’uso di tale ipotesi consente di fare delle previsioni che, poi, non sono confermate dalla realtà sperimentale.

Quale conclusione si può trarre da questa lezione? La memoria dell’acqua semplicemente non esiste.

Andiamo oltre

Altre realtà sperimentali

Concentriamoci ora sul fenomeno della succussione ovvero dell’agitazione meccanica e violenta che, secondo Hannhemann, dinaminizzerebbe l’acqua rendendola capace di accumulare e potenziare l’essenza del principio attivo rendendolo efficace anche alle estreme diluizioni omeopatiche.

Tra le tecniche utilizzate per lo studio degli effetti della succussione sulla struttura dell’acqua sono da annoverare conduttimetria e calorimetria. La conduttimetria è un tipo di analisi attraverso cui si valuta la capacità dell’acqua di condurre la corrente elettrica. La conduttimetria, per esempio, consente di misurare l’effetto Grotthus di cui ho parlato qui. La calorimetria è una tecnica che consente la misura della quantità di energia coinvolta nei processi chimici. In altre parole, l’idea alla base di queste misure è che i processi di diluizione e succussione che portano alla formazione di “impronte”, modificano la rete di legami a idrogeno in cui le molecole di acqua sono coinvolte. Queste modifiche sono individuabili sia attraverso la misura dell’energia (ovvero calore) coinvolta durante le trasformazioni che attraverso le alterazioni temporali delle proprietà conduttimetriche [8].

Sia le indagini conduttimetriche che quelle calorimetriche in cui si conclude che la succussione permette la formazione di strutture acquose coinvolte nelle proprietà dei rimedi omeopatici, sono state smentite in lavori apparsi recentemente in letteratura. Per esempio, Horatio Corti [9] riporta che tutti i lavori in cui si fa uso di conduttimetria soffrono di fallacie metodologiche. Per esempio, quando si descrive la succussione si scrive “violent agitaton”. Cosa vuol dire “agitazione violenta”? Ciò che è “violento” per me potrebbe non esserlo per altri. Sotto il profilo metodologico è sempre – e ribadisco sempre – necessario riportare le condizioni esatte con cui vengono preparati i campioni per le analisi. La base del metodo scientifico è quella di consentire a tutti i ricercatori interessati, di ripetere, se necessario, gli esperimenti fatti dai propri colleghi. Se mancano informazioni, gli esperimenti sono irripetibili ed irriproducibili; i fenomeni di cui si tenta di dare una spiegazione non sono osservabili; quei fenomeni non possono essere descritti e ricadono nell’ambito della pseudo scienza.

Si potrebbe argomentare che in alcuni lavori sia stato indicato che la succussione consiste:

“in a single succussion process, 50–500 vertical strokes are given at the frequency of 0.83 Hz to the vessel containing the solution. In the case of the vortex, the time the vortex was present varied from 20 to 120 s” [10].

In altre parole, la succussione può essere effettuata in due modi. Una prima modalità consiste nell’agitare da 50 a 500 volte dall’alto verso il basso (ovvero in verticale) con una frequenza di 0.83 Hz il contenitore in cui vengono effettuate le diluizioni. Una seconda modalità consiste nell’usare un miscelatore “vortex” per un intervallo di tempo variabile da 20 a 120 s.

Sebbene quanto riportato possa sembrare ineccepibile sotto l’aspetto scientifico, in realtà le informazioni non sono sufficienti affinché la preparazione dei campioni possa essere considerata riproducibile. Infatti, manca l’indicazione relativa alla quantità di energia meccanica coinvolta nel processo di succussione.

In altri studi sui processi di succussione e diluizione, vengono prese in considerazione miscele acqua/biossido di silicio [8]. Ebbene, il biossido di silicio è un composto chimico, presente anche nel vetro, del tutto insolubile in acqua. In funzione delle dimensioni delle particelle di biossido di silicio, si può parlare di dispersione colloidale (particelle di dimensione compresa tra 2 x 10-9 e 2 x 10-6 m, ovvero tra 2 nm e 2 micron) o di sospensione (particelle con dimensione > 2 x 10-6 m, ovvero > 2 micron). È evidente, quindi, che le miscele biossido di silicio/acqua non sono “soluzioni” propriamente dette.

Non essendo delle soluzioni, ma delle dispersioni colloidali o addirittura delle sospensioni, le miscele acqua/biossido di silicio non possono essere campionate in modo riproducibile dal momento che la distribuzione del particolato solido nell’intera miscela dipende fortemente dalla turbolenza del sistema. Si tratta, in definitiva, anche in questo caso di un sistema irriproducibile che non consente ad altri ricercatori di poter controllare la validità delle osservazioni fatte da chi “esalta” la capacità “dinamizzatrice” della succussione.

Cosa dire poi dell’uso di bottiglie scure usate per la conservazione dei campioni? [11] Il colore delle bottiglie è dovuto a composti contenenti nickel, ferro o altri ossidi di metalli di transizione che possono essere rilasciati nelle soluzioni. Queste impurezze, della cui presenza è stato già discusso nel paragrafo precedente in merito ai risultati NMR, possono inficiare sia le misure conduttimetriche che quelle calorimetriche.

Non si può, poi, non ricordare anche che le “agitazioni violente” incrementano la solubilità dei gas in acqua portando alla formazione di nanobolle la cui presenza inficia ogni possibile tipo di analisi si decida di effettuare.

Non è un caso, quindi, che Verdel e Bukovec [12] affermino che quando tutte le possibili fonti di errori sono sotto controllo:

“we found no differences in conductivities of aged mechanically treated solutions and aged untreated solutions”

ovvero la succussione non produce effetti rispetto a soluzioni controllo.

Verdel e Bukovec evidenziano anche che le modifiche temporali nelle misure conduttimetriche dell’acqua possono essere ricondotti ad una proprietà anomala della stessa indicata come tissotropia. La tissotropia è una particolare caratteristica fisica di alcuni gel o liquidi per la quale la viscosità è più elevata in condizioni di riposo, mentre diventa via via più bassa man mano che aumenta l’agitazione meccanica.

Conclusioni I

Questa breve disamina sulle realtà sperimentali in merito all’omeopatia, ha evidenziato che non è vero quanto dicono gli amici dell’omeopatia in merito al mondo scientifico chiuso e sordo alle novità. Si tratta di fantasie di ignoranti che non hanno alcuna idea di come ci si muove nel mondo scientifico. Queste persone, che non hanno idea di cosa sia la Scienza, hanno in mente solo le biografie romanzate di grandi scienziati del passato e pensano che queste biografie romantiche riflettano esattamente il mondo nel quale io stesso mi muovo da circa 25 anni.

Conclusioni II

Anche sotto l’aspetto chimico, l’omeopatia altro non è che una vera e propria scemenza. C’è bisogno di prove per affermarlo? Secondo me, sì. Quando si fanno delle affermazioni in ambito scientifico bisogna sempre parlare con cognizione di causa. Bene hanno fatto i colleghi a fare esperimenti per individuare la validità della cosiddetta memoria dell’acqua. I risultati hanno dimostrato in modo ineccepibile che s tratta di una idea affascinante che, tuttavia, non ha alcun riscontro sperimentale. Si può accantonare senza alcuna difficoltà.

Conclusioni III

Ci sarà sicuramente qualcuno che penserà: “va bene. La memoria dell’acqua non è verificata e quindi non si può considerare. Ma l’omeopatia su di me funziona. Ci sarà qualche altro motivo”.

Il funzionamento dell’omeopatia è legato all’effetto placebo, un effetto non biochimico che si realizza solo in alcune condizioni e che, comunque, non consente di risolvere problemi seri. Ma questo sarà l’oggetto di un’altra nota.

Riferimenti e note

[1] D. Goldenberg (2016) Principles of NMR Spectoscopy, University Science Books; R. Kimmich (2011) NMR: Tomography, Diffusometry, Relaxometry. Springer 2nd ed.

[2] R.R. Conte et al. (1999) Theory of high dilutions and experimental aspects. Paris: Polytechnica. Tradotto e pubblicato da Dynsol Ltd, Huddersfield

[3] LR Milgrom et al. (2001) On the investigation of homeopathic potencies using low resolution NMR T2 relaxation times: an experimental and critical survey of the work of Rolland Conte et al. British Homeopathic Journal, 90: 5-12

[4] JL Demangeat et al. (2004) Low-field NMR water proton longitudinal relaxation in ultrahigh diluted aqueous solutions of silica-lactose prepared in glass material for pharmaceutical use. Applied Magnetic Resonance. 26: 465-481

[5] S Aabel et al. (2001) Nuclear magnetic resonance (NMR) studies of homeopathic solutions. British Homeopathic Journal, 90: 14-20

[6] DJ Anick (2004) High sensitivity 1H-NMR spectroscopy of homeopathic remedies made in water. BMC Complementary and Alternative Medicine, 4: 15 DOI: 10.1186/1472-6882-4-15

[7] S. Baumgartner et al. (2009) High-field 1H T1 and T2 NMR relaxation time measurements of H2O in homeopathic preparations of quarrtz, sulfur, and copper sulfate. Naturwissenschaften, 96: 1079-1089

[8] V. Elia et al. (2004) New physico-chemical properties of extremely diluted aqueous solutions. A calorimetric and conductivity study at 25°C, Journal of Thermal Analysis and Calorimetry, 78: 331–342; V. Elia et al. (2005) Hydrohysteretic phenomena of “Extremely Diluted Solutions” induced by mechanical treatments: a calorimetric and conductometric study at 25 °C. Journal of Solution Chemistry, 34: 947-960; V. Elia et al. (2007) The “Memory of Water”: an almost deciphered enigma. Dissipative structures in extremely dilute aqueous solutions. Homeophaty 96: 163–169; V. Elia et al. (2008) New physico-chemical properties of extremely dilute solutions. A conductivity study at 25 °C in relation to ageing. Journal of Solution Chemistry, 37: 85–96

[9] H.R. Corti (2008) Comments on “New Physico-Chemical Properties of Extremely Dilute Solutions. A Conductivity Study at 25 °C in Relation to Ageing”, Journal of Solution Chemistry 37: 1819–1824

[10] V. Elia et al. (2005) Hydrohysteretic phenomena of “Extremely Diluted Solutions” induced by mechanical treatments: a calorimetric and conductometric study at 25 °C. Journal of Solution Chemistry, 34: 947-960

[11] V. Elia et al. (2004) New physico-chemical properties of extremely diluted aqueous solutions. A calorimetric and conductivity study at 25°C, Journal of Thermal Analysis and Calorimetry, 78: 331–342

[12] N. Verdel e P. Bukovec (2014) Possible further evidence for the thixotropic phenomenon of water, Entropy 16: 2146-2160

Fonte dell’immagine di copertina: ultimi studi