Una delle prime cose che insegno, all’inizio dell’anno accademico nei miei corsi triennale e magistrale, è il metodo scientifico: guardi, ti fai un’idea, provi a smentirla.

Pulito, lineare: tutto misurabile, tutto spiegabile in modo oggettivo e razionale.

Eppure…

C’è stato un tempo in cui avevo la maglia fortunata. Non sostenevo esami senza indossarla. Era la mia coperta di Linus. A nulla valeva ricordarmi che superare un esame dipendesse da me: da quanto avessi studiato e da quanto avessi capito quella disciplina. No: senza il talismano non andavo da nessuna parte. E se venivo bocciato? La risposta era unica e certa: non indossavo il mio “dispositivo apotropaico” perché proprio quel giorno mia madre l’aveva messo a lavare per togliere le puzze.

Dopo cinque anni e una trentina di esami, quella maglia sembrava un gatto spelacchiato sopravvissuto a una centrifuga da 2000 giri al minuto.

Vi sembra stupido, vero? Lo è. Ma sono in buona compagnia. Oggi vi parlo delle abitudini strambe – e poco razionali – di alcuni dei più grandi scienziati passati sulla Terra.

Isaac Newton e la pietra filosofale

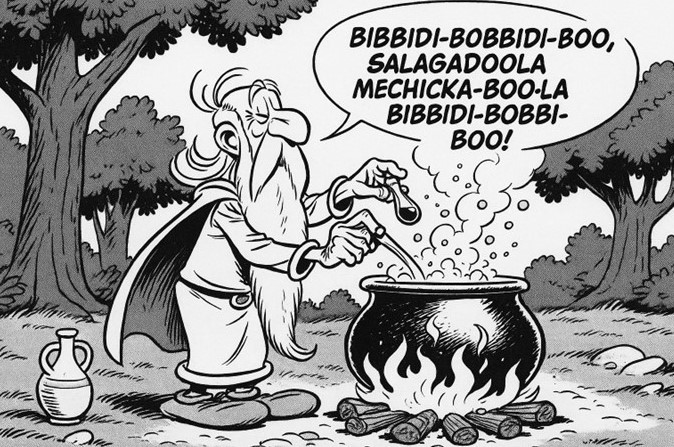

Isaac Newton, simbolo della ragione e dell’ordine matematico, passò anni chinato su testi di alchimia, annotando in latino formule e segni cifrati, vicino alla fornace. Non era un passatempo: era un’ossessione. Cercava la pietra filosofale, il segreto capace di trasmutare i metalli e, in fondo, di svelare il vocabolario nascosto della materia.

Col senno di poi parleremmo di errore concettuale. Eppure quell’alchimia “superstiziosa” conteneva anche i semi della chimica moderna: tecniche di purificazione (sublimazione, calcinazione, distillazione), un’idea operativa di trasformazione, un metodo di laboratorio fatto di prove, fallimenti, registri. Newton non separava nettamente scienza e mistero: cercava leggi nella natura e, insieme, significati nascosti. Forse per questo – scrisse Keynes – “non fu il primo dell’età della ragione, ma l’ultimo dei maghi.”

Dietro la reputazione di glaciale geometra c’era un uomo che alimentava il fuoco del crogiolo di notte, che copiava e commentava pagine e pagine di autori alchemici (tra cui l’enigmatico Eirenaeus Philalethes), che inseguiva il “mercurio filosofico” come chi sospetta l’esistenza di una chiave sola per molte serrature. La sua mano era la stessa che, con pazienza feroce, scomponeva la luce nel prisma: dall’ottica alla gravità, fino alla trasmutazione dei metalli, Newton cercava un principio unificante, un ordine segreto capace di tenere insieme mondi lontani.

C’era anche segretezza: i quaderni alchemici circolavano poco, spesso in codice. Parte per prudenza (il confine con l’eterodossia religiosa era sottile), parte per vanità intellettuale, parte per timore del ridicolo. Ma quelle pagine, così diverse dai Principia, rivelano la stessa postura: occhi sul dettaglio, mani nel laboratorio, mente ostinatamente monoteistica nella sua idea di ordine – un universo costruito con pochi mattoni e poche regole, tutte da decifrare.

È facile sorridere del mago nel matematico. Più difficile è riconoscere che senza quella tenacia quasi rituale, senza notti passate a distillare e fallire, la sua idea di legge naturale non avrebbe avuto la stessa densità. L’alchimia non fu la sua verità scientifica; fu però il suo lessico di apprendistato, il luogo in cui imparò che la materia non si concede a slogan ma a procedimenti. E in questo scarto tra talismano e metodo – tra crogiolo e calcolo – sta il fascino di Newton: un uomo che portò la ragione lontanissimo, senza smettere di ascoltare il richiamo, antico e umano, di un ordine nascosto.

Fermi e la fortuna calcolata

Enrico Fermi, l’uomo che stimava l’energia di un’esplosione nucleare lasciando cadere pezzetti di carta per misurare la distanza d’urto dell’onda, non credeva nella sorte cieca. La misurava. A Los Alamos, nelle pause lunghe come notti, si racconta che facesse conti mentali sulle probabilità di vincere a carte con colleghi altrettanto brillanti: non per denaro, ma per vedere quanto della “fortuna” si potesse spogliare di mistero con un calcolo rapido, un’approssimazione ragionevole, un ordine di grandezza.

La sua erano superstizioni con la matita in mano. Fermi rispettava un principio quasi liturgico: non cambiare un assetto sperimentale che aveva funzionato; ripetere la sequenza di passaggi nello stesso modo, con la stessa cura, quasi con lo stesso ritmo. Non era magia: era metrologia affettiva – l’idea che la regolarità delle cose meriti un cerimoniale minimo perché il rumore non divori il segnale. Nei suoi taccuini la scaramanzia si riduceva a un algoritmo pratico: tieni ferma la procedura, lascia variare una sola cosa alla volta, abbi rispetto per gli strumenti e per i loro capricci.

C’era in lui una fiducia spietata nelle buone stime. I famosi “problemi di Fermi” nascevano da qui: la convinzione che, se scomponi l’ignoto in fattori semplici e plausibili, la realtà si lascia avvicinare. La superstizione, in questo schema, diventa la sorella educata della statistica: non un talismano, ma un set di abitudini che tolgono peso all’ansia e lo spostano sulla ripetibilità. Nel laboratorio come al tavolo da gioco, Fermi domava il caso non negandolo, ma mettendolo al lavoro.

Anche attorno a lui, a Los Alamos, i rituali pullulavano: lavagne ripulite solo a fine turno, gessetti “fortunati”, tazze sempre nello stesso posto. Fermi partecipava con un sopracciglio alzato e un cronometro in tasca. Della fortuna accettava il residuo: quel tanto che resta quando hai contato tutto il contabile. Il resto lo affidava a ciò che sapeva fare meglio – ridurre il mondo a numeri onesti, abbastanza robusti da non crollare alla prima raffica di vento.

È forse qui la sua “scaramanzia”: un rispetto laico per l’ordine. Se qualcosa aveva funzionato ieri, non la si toccava oggi. Non per paura, ma per gratitudine alla regolarità. In quell’interstizio – tra l’onda d’urto misurata con un foglietto e il mazzo di carte ridotto a probabilità – la fortuna smette la maschera e diventa varianza; e Fermi, con calma quasi scaramantica, continua a prenderne le misure.

Niels Bohr e il ferro di cavallo

Niels Bohr, premio Nobel e padre della fisica quantistica, teneva appeso un ferro di cavallo alla porta di casa. Si racconta che, quando un amico gli chiese: “Ma davvero credi che porti fortuna?”, Bohr sorridesse: “No, ma mi hanno detto che funziona anche se non ci credi.” Una battuta che sembra un vezzo, e invece è una piccola lezione di epistemologia domestica.

Bohr viveva nella regione di confine tra ciò che possiamo dire e ciò che possiamo solo prevedere. La sua “complementarità” chiedeva di accettare verità parziali che non possono valere insieme nello stesso esperimento, ma che insieme descrivono il mondo meglio di qualunque assolutismo: onda o particella, a seconda di come guardi. Il ferro di cavallo appeso alla porta diventa allora un’immagine perfetta: una “teoria” pratica che non pretende fede, ma chiede ospitalità. Non serve crederci: basta ammettere che il reale è più scaltro dei nostri schemi e che, nel dubbio, un piccolo rito può convivere con una grande teoria.

C’era ironia in quella risposta, ma non leggerezza. Bohr sapeva che la scienza non elimina l’incertezza: la addomestica. Anche la meccanica quantistica – la più predittiva delle teorie – mette il caso al centro. Niente traiettorie segrete, niente consolazioni classiche: probabilità ben educata, sì; certezza, no. Di fronte a questo, un ferro di cavallo non è un talismano contro la ragione: è una metafora di modestia. Ricorda allo scienziato che i modelli funzionano finché funzionano, e che il mondo non ha il dovere di rientrare nella griglia che abbiamo preparato per lui.

Bohr non chiedeva di credere al ferro, ma di tollerare il paradosso: si può non credere e, tuttavia, lasciare uno spazio all’ignoto, come quando accetti che la luce “sia” onda e particella a seconda della domanda che poni. È il suo stile: una lucidità che non ha paura di tenere in tasca un sorriso. In quell’oggetto appeso alla porta c’è il suo invito più serio: restare intelligenti senza diventare arroganti, custodire i riti minimi che ci aiutano a vivere l’alea, e continuare, nonostante tutto, a misurare, a fare esperimenti, a scegliere bene le domande. Perché la fortuna – qualunque cosa sia – magari non esiste; ma il modo in cui ci disponiamo ad accoglierla può fare tutta la differenza.

Marie Skłodowska Curie e la luce nel buio

Marie Skłodowska Curie portava con sé la sua luce. Non un corno, non un ferro: una piccola fiala di sali di radio che al buio emanava un bagliore azzurrognolo. Più che un portafortuna, era un gesto pratico e insieme poetico: la materia che le aveva cambiato la vita, resa visibile. Le piaceva spegnere le lampade e guardare quel chiarore minimo, come se il mondo le concedesse, per un attimo, di vedere ciò che di solito resta nascosto.

Non era superstizione: era vicinanza alla scoperta. Nei baracconi gelidi dell’Institut du Radium, tra cariole di pechblenda rimescolata per mesi, Marie coltivava una liturgia povera: grembiule, provette, registri fitti, e poi quell’istante notturno in cui controllare se il campione “respirava” luce. Il radio diventava il suo segnaposto nel buio, un promemoria tangibile che la materia parla anche quando tacciamo. Non chiedeva protezione; chiedeva attenzione.

C’era dolcezza e durezza insieme in questo rito. Dolcezza nello stupore – la bellezza di un azzurro che fiorisce da una sostanza nera, quasi un fiat di laboratorio. Durezza nella determinazione: la pazienza feroce di chi riduce, filtra, calcina, misura, annota. Quel filo di luce era la prova che il metodo non è arido: è un modo di stare nelle cose, di non separarsi da ciò che si studia. E, sì, anche un modo di non separarsi da Pierre, perché in quel chiarore c’era la memoria condivisa di un lavoro fatto insieme, quando le notti finivano con le mani stanche e gli occhi pieni di scintille.

Guardiamo oggi a quei gesti con una consapevolezza diversa: taccuini e strumenti di Marie sono ancora radioattivi, custoditi in contenitori piombati. La sua “luce” aveva un prezzo. Ma proprio qui, nel contrasto tra incanto e rischio, il suo rito si fa simbolo: un amuleto laico che non promette fortuna, ma ricorda responsabilità. Tenere una fiala che brilla non per scaramanzia, bensì per fedeltà alla realtà: per dirci che la scienza, quando è grande, non smette di cercare la verità – e di riconoscerne, senza paura, il bagliore.

Richard Feynman e i bonghi quantistici

Richard Feynman, premio Nobel e spirito irrequieto, aveva un rito semplice e scandalosamente terrestre: suonare i bonghi. Prima di una conferenza, la sera di un’idea nuova, perfino tra un calcolo e l’altro: due mani, una pelle tesa, un ritmo che mette ordine. Diceva, senza enfasi, che lo aiutava a entrare nello stato giusto: non tanto la “fortuna”, quanto la frequenza su cui far vibrare attenzione e curiosità.

La sua scienza era una danza tra regole e improvvisazione. Nei diagrammi tracciati col gesso c’era la disciplina di un formalismo elegante; nei bonghi, l’altra metà: la sincope che scioglie l’ansia e fa spazio all’intuizione. Feynman conosceva bene la trappola del controllo assoluto: quando il cervello stringe troppo, l’idea scivola via. Il ritmo serviva a spalancare una finestra, a ricordare al corpo che pensare è anche respirare, che la mente ragiona meglio quando il resto di noi non è in apnea.

Non era una superstizione in cerca di indulgenza, ma una igiene dell’attenzione. Come il disegno (le modelle, i quaderni pieni di linee) o il samba imparato in Brasile, i bonghi facevano parte di una palestra sensoriale con cui Feynman teneva vivo il piacere di scoprire. Un piacere fisico, quasi infantile, che non ha paura di battere le mani su un tamburo prima di battere i denti su un integrale. Il laboratorio, per lui, restava un posto serio; ma la serietà non era seriosità: si poteva arrivare alla verità ridendo, purché si restasse onesti con i dati.

C’era poi una lezione morale, che in Feynman non mancava mai: il rito va bene finché non sostituisce la prova. Nei suoi discorsi contro la “cargo cult science” c’è l’avvertimento netto: i gesti possono aiutare a disporci alla verità, ma non la producono. I bonghi, allora, sono il contrario di un talismano: non promettono risultati, promettono presenza. Ti ricordano che il mondo non si piega alla scaramanzia; si lascia capire, a volte, se entri con il passo giusto.

È facile immaginarlo dietro il sipario: camicia arrotolata, qualche colpo secco, poi un sorriso di bambino colto sul fatto. Il pubblico sente ancora l’eco del tamburo quando Feynman comincia a parlare di particelle come se fossero personaggi su un palcoscenico: entrano, escono, si scambiano segnali. Il ritmo, ormai interno, batte sotto le parole. E quando l’argomento si fa sottile, resta quella musica appena percettibile a tenere insieme rigore e gioia – la vera, inconfondibile firma di Feynman.

Quando la superstizione aiuta la scienza

In realtà, la superstizione – o meglio, il rito – non è l’opposto della scienza. È una scorciatoia mentale che ci fa sentire più stabili davanti all’incertezza. Gli esperimenti falliscono, i risultati tardano, la variabilità domina. A volte un piccolo gesto serve solo a ricordarci che non controlliamo tutto, ma possiamo almeno disporre bene noi stessi.

La psicologia la chiama illusione di controllo: l’idea di poter influenzare un esito incerto attraverso comportamenti ripetitivi. Detto così sembra un difetto; in micro-dose è una risorsa. Il rito abbassa l’ansia basale, ancora l’attenzione e mette il corpo in assetto. È un pre-fallimento controllato: una sequenza che conosciamo a memoria e che ci restituisce padronanza quando il resto è imprevedibile. Il chirurgo che allinea gli strumenti, il violinista che accorda nello stesso ordine, la ricercatrice che riempie la scheda come prima cosa: non è magia, è frizione cognitiva ridotta.

C’è poi un altro effetto, più sottile: il rito sposta il fuoco dall’esito al processo. Per qualche minuto non contano il p-value o il referee n. 2; conta il gesto giusto fatto al momento giusto. Questo disinnesca la ruminazione, che è la vera nemica della performance intellettuale. È come dire alla mente: “riparti da qui, dal concreto”. Da lì tornano il metodo, la misura, la pazienza.

Naturalmente il confine è chiaro: il rito è utile finché resta strumento. Quando pretende di sostituire l’evidenza, diventa superstizione nel senso deteriore: cargo cult. La scienza chiede prove, non propiziazioni. Per questo i rituali buoni sono brevi, economici, falsificabili: se disturbano il dato, si cambiano; se aiutano, restano. Nessun dramma, nessun dogma.

Se volessimo distillare una guida pratica per tenere i riti dalla parte della ragione, potremmo scrivere che essi devono essere:

- Piccoli e ripetibili: un minuto, sempre uguale.

- Non intrusivi: non devono alterare protocollo e misure.

- Orientati al processo: preparano la mente, non “chiamano” l’esito.

- Sostituibili: se non servono più, si lasciano andare senza nostalgia.

Così il rito smette di essere una scialuppa contro il caso e diventa un metronomo: batte il tempo mentre facciamo ciò che davvero conta – osservare, ipotizzare, verificare. E quando, finalmente, il risultato arriva, non diremo “ha funzionato il portafortuna”, ma qualcosa di più adulto e più bello: ho lavorato bene, nel modo giusto.

Superstizioni d’alta quota

Anche oggi, tra scienziati e astronauti, i riti non mancano. Non chiedono fede: aiutano a respirare quando l’alea è alta.

- Baikonur, la sosta più famosa. Da Gagarin in poi, i cosmonauti russi si fermano ancora accanto alla ruota posteriore del bus che li porta alla rampa. I maschi… urinano; alcune colleghe versano poche gocce da una fialetta, per tradizione. È un gesto semplice e spiazzante, nato dal bisogno e diventato rito: un modo per dire “si parte, ma restiamo umani”.

- Cape Canaveral, liturgie di routine. In ambiente NASA abbondano abitudini “portaserenità”: la colazione di steak & eggs nel giorno di lancio, una mano di carte finché il comandante perde, e persino le noccioline “della fortuna” al JPL, nate con Ranger 7. Piccoli gesti che non spostano i numeri, ma allineano le teste.

- Amuleti a gravità zero. Quasi ogni equipaggio porta a bordo un peluche: è simpatico, certo, ma soprattutto è un indicatore innocuo di microgravità — quando inizia a fluttuare, sai che sei in orbita. Una superstizione con funzione strumentale.

- CERN, ironia ad alta energia. Nei corridoi del laboratorio circolano tazze, meme e particelle di peluche: l’autoironia come rito collettivo durante le fasi delicate dell’LHC. Non “propiziazioni”, ma talismani laici che ricordano che dietro al Bosone di Higgs ci sono persone. (Curiosità: esistono intere collezioni di plush del Modello Standard; persino Peter Higgs teneva il suo come fermacarte.)

La logica è sempre la stessa: abbassare il rumore interno. Che tu stia entrando in una Soyuz o accendendo un acceleratore, un rito minuscolo può trasformare l’ansia in gesto, e il gesto in attenzione operativa. Non cambia la fisica; cambia chi la maneggia. E, a quelle altitudini – letterali o metaforiche – è già tantissimo.

L’ultima mossa della ragione

La superstizione, vista da vicino, è spesso una regola empirica ante litteram: “ogni volta che faccio così, va meglio”. Una scorciatoia nata dall’esperienza. La domanda giusta non è crederci o no, ma perché sembra funzionare – e se funziona davvero. Qui la ragione fa la sua mossa: prende il rito, lo mette alla prova, lo tiene se aiuta il processo, lo lascia se inganna.

Newton cercava oro, e trovò leggi. Fermi mescolava carte, e scoprì il caso come alleato, non come nemico. Bohr appese un ferro di cavallo e ci ricordò che l’ironia può essere una forma di pensiero. Marie Skłodowska Curie guardò una fiala che brillava e trasformò l’incanto in misura. Feynman batteva i bonghi e convertiva l’ansia in attenzione.

Il punto è questo: i riti sono trampolini, non arrivi. Ti danno lo slancio per saltare, ma a metà aria devi affidarti alle prove. Quando la superstizione accetta questo patto – restare piccola, utile, rivedibile – smette di essere un alibi e diventa l’ultima cortesia che facciamo alla mente prima di chiedere alla realtà la sua risposta.

Epilogo

E se qualcuno mi chiedesse se credo nella fortuna, risponderei come Bohr: «No, ma mi hanno detto che funziona anche se non ci credi».

Poi, in silenzio, ripiegherei la mia vecchia maglia: i riti passano, il metodo resta.

Note e riferimenti

- Isaac Newton e l’alchimia: dettagli in “The Foundations of Newton’s Alchemy, or the Hunting of the Greene Lyon” e “The Janus Faces of Genius” di Betty Jo Teeter Dobbs; Vincenzo Schettino, “Isaac Newton and Alchemy”, Substantia, Firenze University Press.

- Niels Bohr: l’aneddoto del ferro di cavallo è riportato in “Bartlett’s Book of Anecdotes” e su “Today in Science Quotes”.

- Richard Feynman: episodi sui bonghi in “Surely You’re Joking, Mr. Feynman.”

- Marie Curie: menzione della fiala di radio e del fascino per il bagliore notturno in “Obsessive Genius: The Inner World of Marie Curie” di Barbara Goldsmith.

- Enrico Fermi: per “foglietti di carta” e stima dell’onda d’urto: Atomic Heritage Foundation, “Trinity Test Eyewitnesses: Enrico Fermi” (riporta la sua descrizione in prima persona).

- Enrico Fermi: Per il ritratto del metodo/abitudini: Laura Fermi, Atoms in the Family e Emilio Segrè, Enrico Fermi: Physicist.