Gestisco da un po’ di tempo diverse pagine e gruppi di carattere scientifico e aiuto, per il poco che so fare, nella pagina Bufale e Dintorni a “sbufalare” quelle pochissime cose di cui mi intendo e che sono legate esclusivamente alla chimica.

Ho notato che tutti i gruppi e le pagine sono animate da persone che hanno un atteggiamento scettico di fronte a cose improbabili e tutti si dicono amanti della scienza.

Ultimamente, però, sto ponendo particolare attenzione all’omeopatia e al fatto che si basa sul nulla. Ciò che salta subito agli occhi quando vado a visualizzare le statistiche delle pagine è un deflusso di “like” ogni volta che si affronta questo argomento. Si osserva quello che studiosi del settore definiscono “polarizzazione”, ovvero rimangono ad “ascoltare” ciò che c’è da dire solo coloro che la pensano nello stesso modo del/dei gestore/i della pagina. Ne viene che anche le persone che si dicono scettiche ed amanti della verità scientifica hanno difficoltà ad accettare discussioni oggettive su argomenti che vanno a toccare certi aspetti della loro sensibilità.

Mi sono sempre chiesto perché accada una cosa del genere. Perché persone che si dicono amanti della scienza si comportano come i “complottari” contro cui in altre circostanze e per altri argomenti si scagliano?

Non sono uno psicologo, né uno studioso di comportamento umano per cui le mie riflessioni sono solo soggettive e non hanno nessuna pretesa.

Da ingenuo, ho sempre pensato che tutti quelli che sono senza adeguata preparazione scientifica sono anche coloro che per primi non sono in grado di sostenere argomentazioni oggettive. Ma non è così. Ho potuto notare che anche tra gli insospettabili miei colleghi ci sono quelli che non accettano il contraddittorio su certe argomentazioni o prendono sul personale dei miei commenti che non hanno alcuna velleità ad hominem (per non parlare di quelli che sono iper specializzati nel loro settore ma pensano di poter mettere bocca su tutto facendo poi figure barbine quando dimostrano la loro incompetenza in campi di cui conoscono solo il nome). Anche io stesso mi rendo conto di avere difficoltà ad accettare certe posizioni contrarie alle mie convinzioni.

Rispetto a chi non ha una adeguata preparazione scientifica, chi si occupa di scienza è un po’ più allenato a riconoscere i pregiudizi di conferma, ma c’è comunque un punto oltre il quale non si riesce ad andare. È perché oltre una certa età ci si innamora delle proprie idee e dei propri modelli? Si è troppo innamorati di se stessi come ho già detto altrove [1]? Forse la molla narcisistica è accentuata in tutti noi?

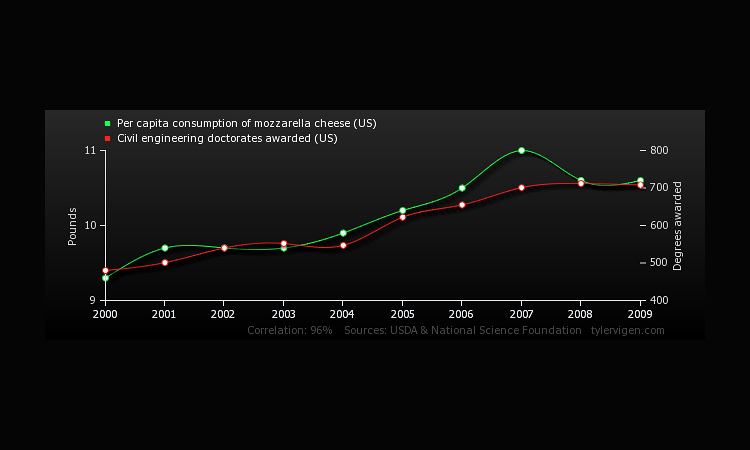

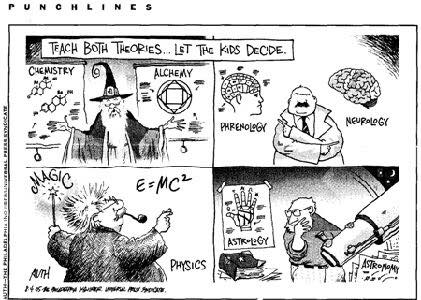

Qualcuno ha risposto evidenziando che le persone tendono a ritenere come poco importanti le contro argomentazioni alle loro convinzioni selezionando in questo modo solo i dati sperimentali che consentono di confermare il proprio modo di pensare [2]. Si tratta di ciò che viene definito cherry picking. Altri, studiando il comportamento nei social network, hanno raccolto un gran numero di dati in base ai quali è possibile riconoscere nel comportamento di ognuno una selezione della propria echo chamber (camera dell’eco in cui risuona un solo modo di pensare) in modo tale da sentirsi al sicuro e protetti [3].

Sebbene non sia detto esplicitamente da nessuna parte, forse perché gli autori che ho citato non sono specialisti in biologia evolutiva (nemmeno io lo sono, ma su Facebook mi posso spingere oltre per innescare un dialogo con i miei lettori più esperti), mi sono convinto che un comportamento del genere, ovvero la creazione delle echo chambers, sia qualcosa di atavico legato alle epoche in cui l’essere umano si aggregava in micro società in cui tutti avevano come obiettivo comune la sopravvivenza del gruppo attraverso la protezione dei singoli individui della comunità. La trasposizione in chiave internettiana delle tribù primitive si traduce, quindi, nella cosiddetta polarizzazione che porta ognuno di noi a spegnere la razionalità su certi particolari argomenti e circondarsi solo di persone che la pensano come noi.

Si può fare qualcosa? Forse solo lo sviluppo culturale può contrastare una esigenza primordiale, ma occorre tempo e, per quanto ne posso capire io che esperto non sono, siamo ancora agli inizi.

Riferimenti

[1] https://www.facebook.com/RinoConte1967/posts/1911049185783275:0

[2] https://phys.org/…/2017-01-facts-beliefs-identity-seeds-sci…

[3] W. Quattrociocchi et al 2016, Misunderstanding, Edagricoke