Quante volte ho dovuto leggere “su di me funziona” da parte dei fautori dell’omeopatia come risposta ai miei ripetuti post sull’argomento omeopatia? I vari interventi si trovano nei riferimenti [1-6]Adesso cerco di spiegare perché questa affermazione non ha alcuna validità e denota solo ignoranza scientifica da parte di chi la sostiene. A tale scopo faccio un esempio banale considerando che ognuno di noi è in grado di rispondere in un determinato modo alla somministrazione di una particolare sostanza o un alimento.

Supponiamo che due persone prese a caso assumano del latte. Si possono verificare le seguenti condizioni:

1. Entrambe le persone vivono senza problemi di sorta la loro vita (ok, ok)

2. Una delle due persone vive normalmente, l’altra ha problemi di meteorismo, dolori di stomaco, gonfiore e tutto quanto si può associare ad una intolleranza all’alimento che gli è stato somministrato (ok, no)

3. Entrambe le persone hanno problemi (no, no)

Se ci limitassimo all’analisi della sola condizione 1. saremmo tentati di dire che il latte è un alimento che fa bene a tutti. In altre parole estenderemmo all’intera popolazione umana quelle che sono le osservazioni fatte su soli due individui. In questo modo non terremmo conto di ciò che accade nella condizione 2., ovvero che la scelta casuale di due persone per condurre un esperimento sulla salubrità del latte potrebbe portare ad una situazione in cui non sappiamo se il latte fa bene oppure no alla salute umana. Infatti uno dei due individui non ha conseguenze, l’altro, invece, mostra intolleranz. Non terremmo conto neanche della condizione 3., per la quale, scelte due persone a caso, entrambe risultano intolleranti.

Per dirimere la questione dobbiamo introdurre una terza persona. Dobbiamo, cioè, scegliere un terzo individuo in modo casuale e osservare l’effetto del latte sul suo organismo. Anche in questa situazione si possono verificare due condizioni:

A. L’individuo non mostra sintomi di intolleranza (ok)

B. L’individuo mostra sintomi di intolleranza (no)

Le condizioni 1., 2. e 3. si possono combinare con le condizioni A. e B. nel seguente modo:

1A, 1B, 2A e 2B, 3A e 3B.

Dalla condizione 1A (cioè ok, ok, ok) potremmo concludere che il latte non dà alcun problema. Dalle situazioni 1B e 2A (ovvero ok, ok, no) potremmo, invece, concludere che il latte fa bene ai 2/3 della popolazione umana. Le situazioni 2B e 3A (corrispondenti a ok, no, no ) ci conducono alla conclusione opposta, ovvero che il latte fa male ai 2/3 della popolazione umana. La condizione 3B (no, no, no) ci porta a concludere che l’intera popolazione umana è intollerante al latte.

In definitiva, prendendo prima due e poi tre individui a caso, non abbiamo risposto alla domanda: qual è l’effetto del latte sulla salute umana? Il latte offre vantaggi o svantaggi? In effetti, il numero limitato di casi presi in considerazione non ci permette di dare una risposta definitiva al nostro problema.

Cosa fare allora? Bisogna estendere l’indagine ad un numero statisticamente significativo di individui umani, differenziandoli per età, sesso, origine etnica e condizioni di salute.

Per “numero statisticamente significativo” si intende un numero di individui che sia, nel suo insieme, rappresentativo della totalità degli individui di una popolazione. Alla luce dei risultati osservati si può fare una statistica e dire che su tanti individui , indichiamoli con 100, un certo numero, indichiamolo Z con Z<100, è tollerante al latte, mentre un numero pari a 100-Z è intollerante. All’interno del campione Z ci può essere un numero, M, di maschi ed un numero, F, di femmine (M+F=Z) ed all’interno delle singole popolazioni ci può essere un certo numero di Italiani, Svizzeri, Danesi e così via di seguito. Lo stesso si applica al numero di individui pari a 100-Z.

Grazie a questa impostazione sperimentale, la variabilità comportamentale dei singoli individui viene inglobata in una casistica che consente di dire che in media il latte fa bene, ma che un certo numero di persone possono mostrare delle intolleranze che si possono spiegare – in uno stadio successivo dell’indagine – alla luce dell’attività pastorizia che ha luogo in un certo ambiente e della diffusione genetica di certe caratteristiche di tolleranza/intolleranza.

Chi afferma che qualcosa funziona sul suo organismo per cui quel qualcosa, in base alla sua opinione, ha un certo tipo di attività, palesemente dichiara, senza alcuna vergogna -perché dimostra solo che le lezioni avute a scuola sono state del tutto inutili, di non conoscere il metodo scientifico e di come esso si applichi alle indagini sugli esseri viventi. I casi soggettivi non sono utili. Devono sempre essere inglobati in una moltitudine di casi che, tutti insieme, consentono di estrapolare il comportamento medio di fronte alla somministrazione di un preparato, un farmaco o un alimento che sia.

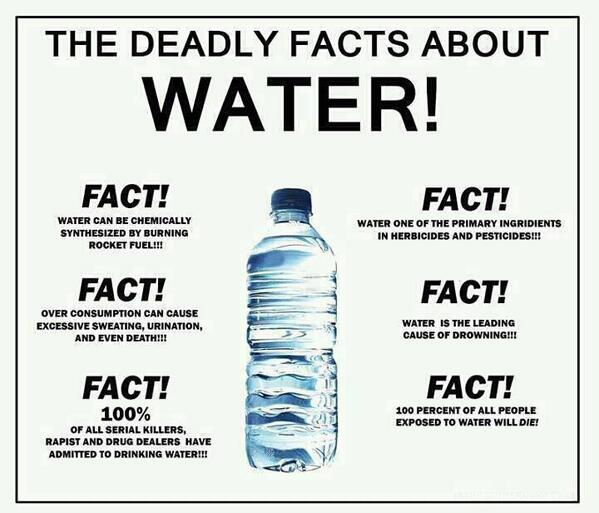

Tutto quanto detto, comunque, non è sufficiente alle conclusioni di cui ho discusso. Infatti, è possibile che tra gli individui scelti a caso ci siano degli ipocondriaci a cui il latte non dà fastidio ma che, per partito preso, perché non gli piace o quant’altro, affermano che la somministrazione di latte ha portato loro dei problemi. Per ovviare a questa situazione, ovvero per evitare che i risultati dell’indagine siano influenzati dai propri atteggiamenti ipocondriaci, le indagini sulla popolazione di individui statisticamente significativa deve essere condotta in modo tale che a un certo numero di individui venga somministrato latte, ad un altro numero un materiale simile al latte ma che latte non è.

Sia gli individui soggetti all’esperimento che gli sperimentatori non sanno cosa viene somministrato in modo tale da evitare che anche involontariamente le caratteristiche dell’alimento somministrato possano essere rese note. Questo esperimento, che si chiama “in doppio cieco”, assicura che convinzioni soggettive in merito alla somministrazione di latte (o qualunque altra cosa) possano non alterare i risultati dello studio.

Una breve disanima sul metodo scientifico usato nel settore biologico/biochimico/medico la si trova nel riferimento [7], mentre nel riferimento [8] si trova un interessante lavoro sul perché la procedura omeopatica deve essere rigettata anche solo a livello logico-filosofico.

Nel caso particolare dell’omeopatia si è verificato che:

1. gli esperimenti per valutare l’effetto dei preparati omeopatici sono condotti in grandissima parte senza alcun controllo rispetto a placebo e farmaci reali [9, 10]

2. Nei casi in cui il controllo è stato condotto e gli esperimenti fatti in doppio cieco, i preparati omeopatici non sono risultati migliori dei placebo [11-13]

3. Sia negli esperimenti su bambini che in quelli su animali condotti con i crismi del metodo scientifico sommariamente illustrato sopra, i preparati omeopatici hanno dimostrato solo effetto placebo [14]

In definitiva, quando i fautori dell’omeopatia affermano che un certo preparato funziona perché a loro sembra di trarne benefici, bisogna prendere atto che si sta interloquendo con delle persone che hanno problemi di tipo non biochimico e che hanno principalmente bisogno di attenzione; quella attenzione che pagano a caro prezzo affidandosi ad imbonitori che, attraverso parole bonarie e finta empatia, prescrivono preparati inutili sotto l’aspetto farmacologico.

Riferimenti

1. https://www.facebook.com/RinoConte1967/posts/1937902003097993:0

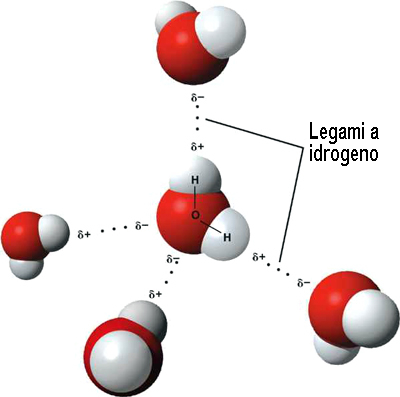

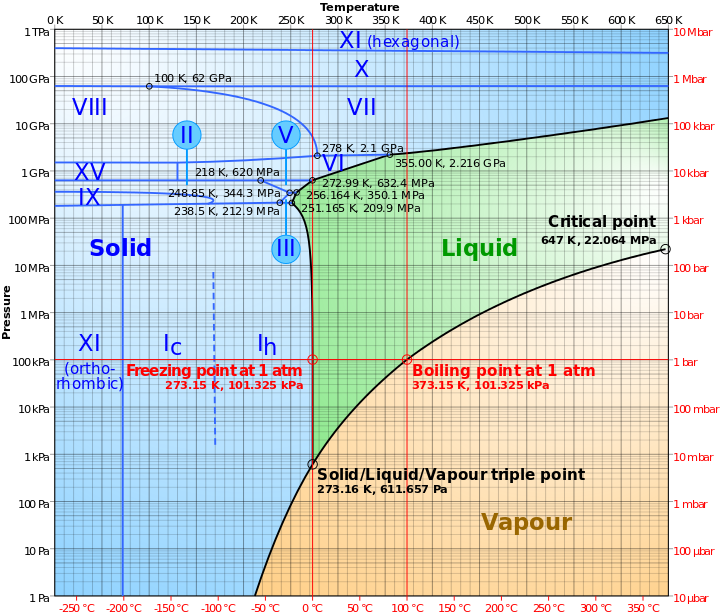

2. https://www.facebook.com/notes/rino-conte/la-memoria-dellacqua-lomeopatia-ed-i-pregiudizi-di-conferma/1919125418308985

3. https://www.facebook.com/RinoConte1967/posts/1915078438713683

4. https://www.facebook.com/RinoConte1967/photos/a.1652785024943027.1073741829.1652784858276377/1909420659279461/?type=3

5. http://www.laputa.it/omeopatia/

6. https://www.facebook.com/RinoConte1967/posts/1798823550339173:0

7. https://www.scienzeascuola.it/lezioni/biologia-generale/il-metodo-scientifico-o-sperimentale

8. http://onlinelibrary.wiley.com/doi/10.1111/j.1365-2753.2010.01384.x/full

9. https://www.ncbi.nlm.nih.gov/pmc/articles/PMC1668980/pdf/bmj00112-0022.pdf

10. http://www.dcscience.net/Smith-response.pdf

11. http://www.homeopathonline.net/library/Are%20the%20clinical%20effects%20of%20homoeopathy%20placebo%20effects.pdf

12. http://jamanetwork.com/journals/jamasurgery/fullarticle/211818?wptouch_preview_theme=enabled

13. https://www.ncbi.nlm.nih.gov/pubmed/11055773

14. http://onlinelibrary.wiley.com/doi/10.1111/j.1751-0813.2007.00174.x/full