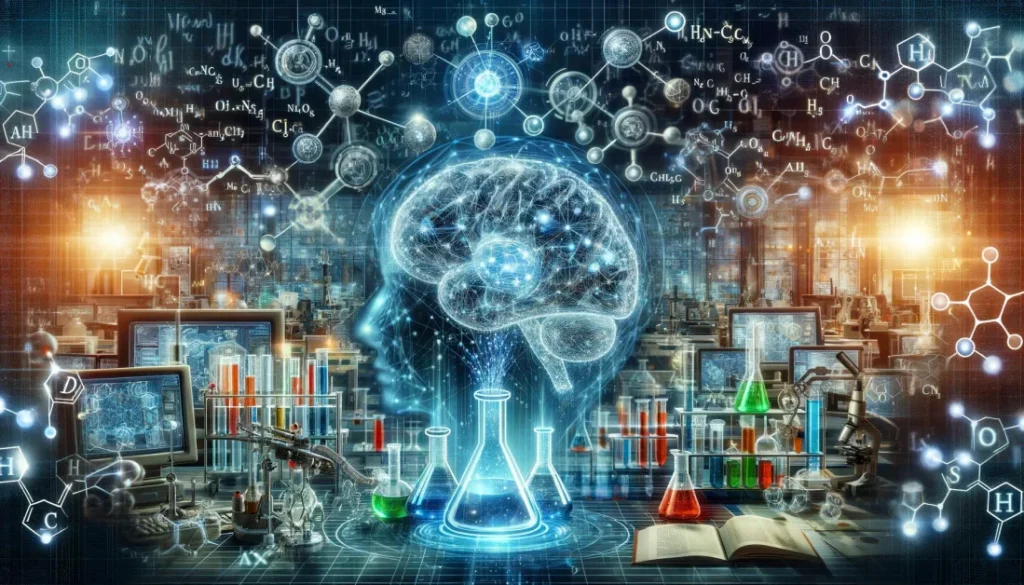

Avrete sicuramente notato che oggi l’intelligenza artificiale (AI) sta diventando una presenza sempre più costante nelle nostre vite. Sono tantissimi gli ambiti in cui l’AI riesce a sostituire con successo l’essere umano. Si potrebbe dire che questa rivoluzione sia iniziata molto tempo fa, con i primi robot che hanno cominciato a svolgere compiti ripetitivi al posto dell’uomo, come nelle catene di montaggio o, più drammaticamente, nei contesti bellici, dove i droni sono diventati strumenti chiave per ridurre il numero di vittime umane.

Negli ultimi anni, lo sviluppo vertiginoso delle reti neurali artificiali ha portato alla nascita di veri e propri “cervelli digitali” che, presto, anche se non sappiamo quanto presto, potrebbero avvicinarsi, per certi aspetti, alle capacità del cervello umano.

Nel frattempo, però, l’intelligenza artificiale già funziona alla grande ed è sempre più presente in numerosi settori, tra cui la chimica, che rappresenta uno dei campi più promettenti.

All’inizio può sembrare curioso accostare molecole, reazioni chimiche e leggi della fisica a concetti come algoritmi e reti neurali. Eppure, l’unione di questi mondi sta rivoluzionando il modo in cui facciamo ricerca, progettiamo nuovi materiali, affrontiamo le sfide ambientali e persino come insegniamo la scienza.

Ma cosa significa, concretamente, applicare l’intelligenza artificiale alla chimica?

Scoprire nuove molecole (senza provare tutto in laboratorio)

Uno degli ambiti in cui l’intelligenza artificiale si è rivelata più utile è la scoperta di nuovi composti chimici. Fino a qualche tempo fa, per trovare una molecola utile, un farmaco, un catalizzatore, un materiale con proprietà particolari, bisognava fare molti tentativi sperimentali, spesso lunghi e costosi.

Negli ultimi decenni, la chimica computazionale ha cercato di alleggerire questo carico, permettendo ai ricercatori di simulare al computer il comportamento di molecole, reazioni e materiali. Tuttavia, anche le simulazioni più avanzate richiedono molto tempo di calcolo e competenze specialistiche, oltre ad avere dei limiti nella scala e nella complessità dei sistemi che si possono trattare.

Qui entra in gioco l’intelligenza artificiale: grazie a modelli di machine learning sempre più raffinati, è possibile prevedere rapidamente il comportamento di una molecola, come la sua stabilità, la reattività, o la capacità di legarsi a un bersaglio biologico, semplicemente a partire dalla sua struttura. Questi algoritmi apprendono da enormi quantità di dati sperimentali e teorici e sono in grado di fare previsioni accurate anche su molecole mai testate prima.

In altre parole, l’AI sta cominciando a superare i limiti della chimica computazionale tradizionale, offrendo strumenti più rapidi, scalabili e spesso più efficaci nel guidare la ricerca. Invece di provare tutto in laboratorio (o simulare tutto al computer), oggi possiamo usare modelli predittivi per concentrare gli sforzi solo sulle ipotesi più promettenti.

Cosa vuol dire “machine learning”?

Il machine learning, o apprendimento automatico, è una branca dell’intelligenza artificiale che permette a un computer di imparare dai dati. Invece di essere programmato con regole rigide, un algoritmo di machine learning analizza una grande quantità di esempi e impara da solo a riconoscere schemi, fare previsioni o prendere decisioni.

È un po’ come insegnare a un bambino a distinguere un cane da un gatto: non gli spieghi la definizione precisa, ma gli mostri tante immagini finché impara da solo a riconoscerli.

Nel caso della chimica, l’algoritmo può “guardare” migliaia di molecole e imparare, per esempio, quali caratteristiche rendono una sostanza più solubile, reattiva o stabile.

Simulare ciò che non possiamo osservare

In molti casi, la chimica richiede di capire cosa succede a livello atomico o molecolare, dove gli esperimenti diretti sono difficili, costosi o addirittura impossibili. Ad esempio, osservare in tempo reale la rottura di un legame chimico o l’interazione tra una superficie metallica e un gas può essere tecnicamente molto complicato.

Qui entrano in gioco la chimica computazionale e, sempre di più, l’intelligenza artificiale. I metodi classici di simulazione, come la density functional theory (DFT) o le dinamiche molecolari, permettono di studiare reazioni e proprietà microscopiche con una certa precisione, ma sono spesso limitati dalla potenza di calcolo e dal tempo necessario per ottenere risultati.

L’AI può affiancare o persino sostituire questi metodi in molti casi, offrendo simulazioni molto più rapide. Gli algoritmi, addestrati su grandi insiemi di dati teorici o sperimentali, riescono a prevedere energie di legame, geometrie molecolari, traiettorie di reazione e persino comportamenti collettivi di materiali complessi, con un livello di precisione sorprendente.

Questo approccio è particolarmente utile nella chimica dei materiali, nella catalisi e nella chimica ambientale, dove le condizioni reali sono dinamiche e complesse, e spesso è necessario esplorare molte variabili contemporaneamente (temperatura, pressione, pH, concentrazione, ecc.).

In sintesi, grazie all’AI, oggi possiamo “vedere” l’invisibile e testare ipotesi teoriche in modo veloce e mirato, risparmiando tempo, denaro e risorse. La simulazione assistita dall’intelligenza artificiale sta diventando una delle strategie più promettenti per affrontare problemi scientifici troppo complessi per essere risolti con i soli strumenti tradizionali.

Insegnare (e imparare) la chimica in modo nuovo

Anche il mondo dell’istruzione sta vivendo una trasformazione grazie all’intelligenza artificiale. La didattica della chimica, spesso considerata una delle materie più “dure” per studenti e studentesse, può oggi diventare più coinvolgente, personalizzata ed efficace proprio grazie all’uso di strumenti basati su AI.

Uno dei vantaggi principali è la possibilità di adattare il percorso di apprendimento alle esigenze del singolo studente. Grazie a sistemi intelligenti che analizzano le risposte e i progressi individuali, è possibile proporre esercizi mirati, spiegazioni alternative o materiali supplementari in base al livello di comprensione. Questo approccio personalizzato può aiutare chi è in difficoltà a colmare lacune e, allo stesso tempo, stimolare chi è più avanti ad approfondire.

L’AI può anche contribuire a rendere la chimica più visiva e interattiva. Alcune piattaforme, ad esempio, usano modelli predittivi per generare visualizzazioni 3D di molecole, reazioni chimiche o strutture cristalline, rendendo più intuitivi concetti spesso astratti. In più, i chatbot educativi (come quelli alimentati da modelli linguistici) possono rispondere a domande in tempo reale, spiegare termini complessi in modo semplice o simulare piccoli esperimenti virtuali.

Un’altra frontiera interessante è quella della valutazione automatica e intelligente: sistemi di AI possono correggere esercizi, test e report di laboratorio, offrendo feedback tempestivo e accurato. Questo libera tempo per l’insegnante, che può concentrarsi sulla guida e sul supporto più qualitativo.

Infine, l’intelligenza artificiale può aiutare anche chi insegna: suggerendo materiali didattici aggiornati, creando quiz su misura per ogni lezione, o analizzando l’andamento della classe per identificare i concetti che vanno ripresi o approfonditi.

In sintesi, l’AI non sostituisce il docente o il laboratorio, ma li potenzia, offrendo nuovi strumenti per rendere l’insegnamento della chimica più accessibile, efficace e stimolante.

Una rivoluzione che non sostituisce il chimico

Di fronte a questi progressi, è naturale chiedersi: quale sarà allora il ruolo del chimico nel futuro? La risposta è semplice: sarà sempre più centrale, ma in modo diverso.

L’intelligenza artificiale è uno strumento potente, ma resta pur sempre uno strumento. Può accelerare le ricerche, suggerire ipotesi, esplorare combinazioni complesse o evidenziare correlazioni nascoste. Ma non può, da sola, sostituire la competenza critica, l’intuizione, l’esperienza e la creatività che solo un/una chimico/a formato/a può offrire.

Un errore molto comune, oggi, è considerare l’AI come una sorta di enciclopedia moderna, da cui si possano estrarre risposte esatte, univoche, perfette. Ma la chimica non funziona così e neppure l’intelligenza artificiale. Entrambe si muovono su terreni complessi, fatti di ipotesi, interpretazioni, modelli e approssimazioni. Pretendere dall’AI risposte definitive senza saper valutare, filtrare o indirizzare i risultati è un rischio.

Proprio come un bambino brillante, l’AI va educata e guidata. Ha bisogno di esempi buoni, di dati corretti, di domande ben formulate.

E, soprattutto, ha bisogno di essere “letta” da occhi esperti, capaci di interpretare e contestualizzare quello che produce.

In chimica, come nella scienza in generale, la conoscenza non è mai solo questione di calcoli o statistiche: è anche, e soprattutto, comprensione profonda dei fenomeni.

Quindi, piuttosto che temere l’arrivo dell’intelligenza artificiale, dobbiamo imparare a collaborarci con intelligenza.

Il chimico del futuro non sarà un tecnico che esegue, ma un regista che sa orchestrare strumenti nuovi per rispondere a domande sempre più complesse. Ed è proprio questa, forse, la sfida più stimolante dei nostri tempi.

Riferimenti

Aldossary & al. (2024) In silico chemical experiments in the Age of AI: From quantum chemistry to machine learning and back. ChemRxiv. 2024; Doi: 10.26434/chemrxiv-2024-1v269. Disponibile al link: https://chemrxiv.org/engage/chemrxiv/article-details/65cdf1309138d231612baac8.

Anjaneyulu & al. (2024) Revolution of Artificial Intelligence in Computational Chemistry Breakthroughs. Chemistry Africa 7, 3443–3459. https://doi.org/10.1007/s42250-024-00976-5.

Blonder & Feldman-Maggor (2024) AI for chemistry teaching: responsible AI and ethical considerations. Chemistry Teacher International 6(4), 385–395. https://doi.org/10.1515/cti-2024-0014.

Dral (2024) AI in computational chemistry through the lens of a decade-long journey. Chemical Communications. 60, 3240-3258. https://doi.org/10.1039/D4CC00010B.

Dral, Bowman, Liu, Maseras (editors) (2024) Artificial intelligence in computational chemistry (special issue). Disponibile al link: https://www.sciencedirect.com/special-issue/105PZW0WJF7.

Kovner & Berkeley (2024) ‘AI-at-scale’ method accelerates atomistic simulations for scientists. Disponibile al link: https://techxplore.com/news/2024-12-ai-scale-method-atomistic-simulations.html.

Kovner & Berkeley (2025) Computational chemistry unlocked: A record-breaking dataset to train AI models has launched. Disponibile al link: https://phys.org/news/2025-05-chemistry-dataset-ai.html.

Nongnuch & al. (2021) Best practices in machine learning for chemistry. Nature Chemistry 13, 505–508. https://doi.org/10.1038/s41557-021-00716-z.

Yuriev & al. (2024) The Dawn of Generative Artificial Intelligence in Chemistry Education. Journal of Chemical Education 101, 2957-2929. https://doi.org/10.1021/acs.jchemed.4c00836.

Udourioh & al. (2025) Artificial Intelligence-Driven Innovations in Chemistry Education: Transforming Teaching and Learning Practices. In: Handbook on Artificial Intelligence and Quality Higher Education. Volume 1 (pp.379-388). Publisher: Sterling Publishers, Slough UK and Delhi, India. Disponibile al link: https://www.researchgate.net/publication/388675124_Artificial_Intelligence-Driven_Innovations_in_Chemistry_Education_Transforming_Teaching_and_Learning_Practices.

Zhang & al. (2025) Artificial intelligence for catalyst design and synthesis. Matter 8, 102138. https://doi.org/10.1016/j.matt.2025.102138.