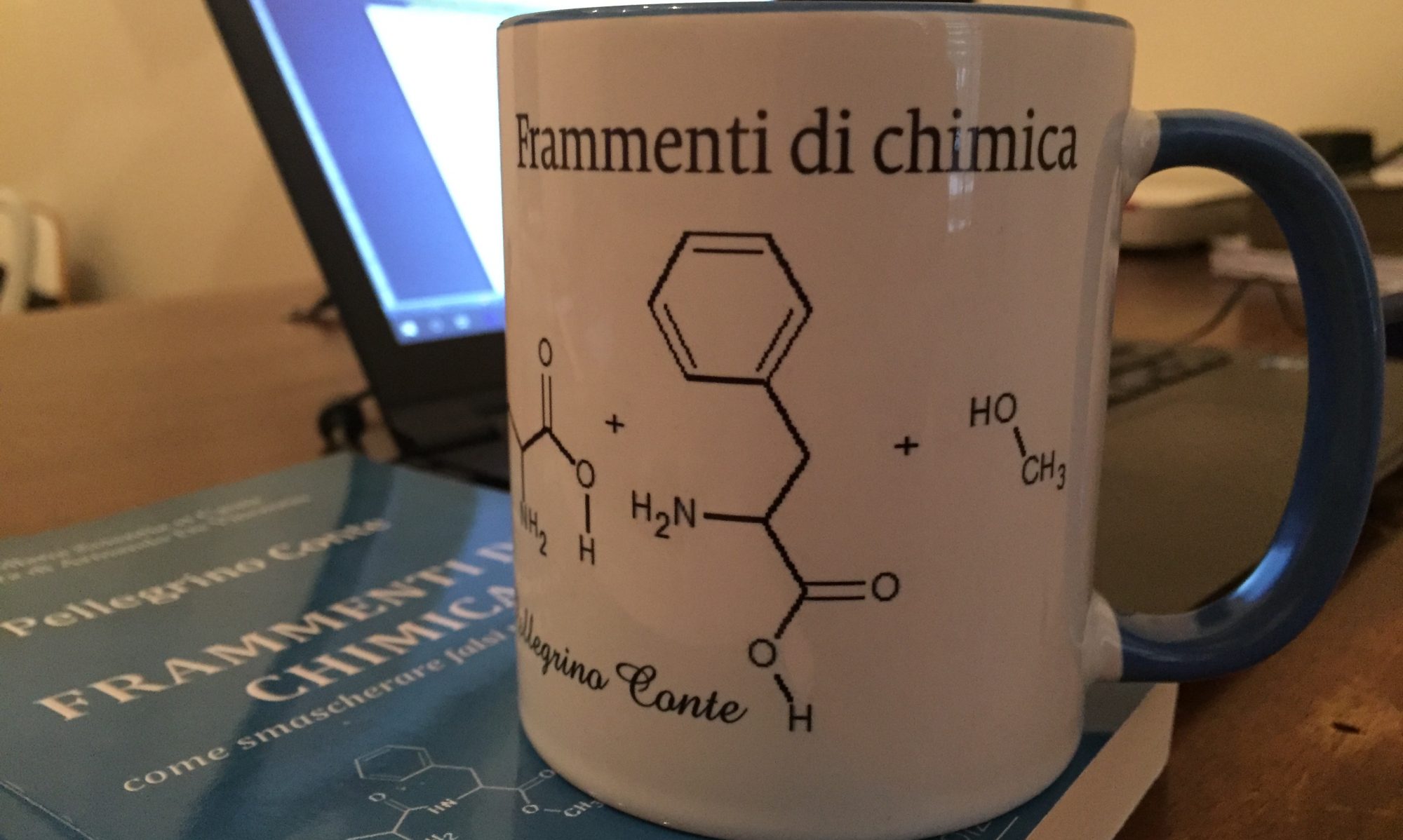

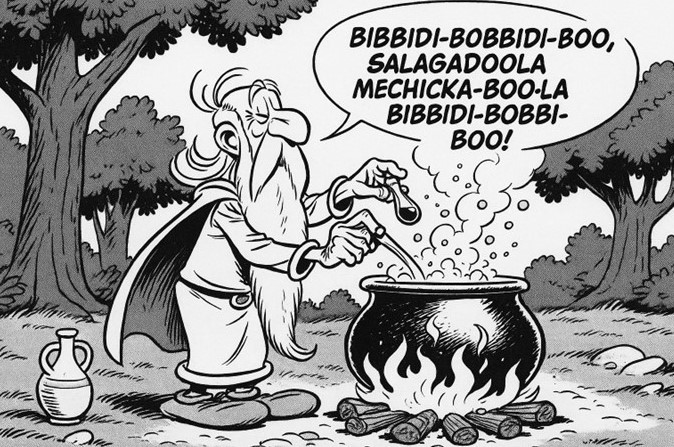

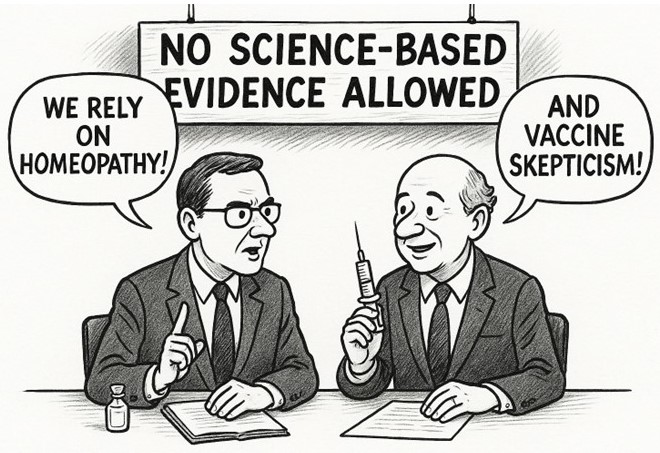

Frequento i social network dal 2009 e, qualche anno dopo – era il 2015, ormai dieci anni fa – ho aperto il mio blog. All’inizio, da neofita, mi ritrovavo a discutere animatamente con persone di ogni tipo: rabdomanti convinti di sentire l’acqua con un bastoncino, cacciatori di fantasmi armati di telecamerine, fan dell’omeopatia pronti a difendere il niente travestito da nulla diluito e sostenitori dell’agricoltura biodinamica intenti a recitare formule magiche come i druidi di Asterix per aumentare la produttività dei campi.

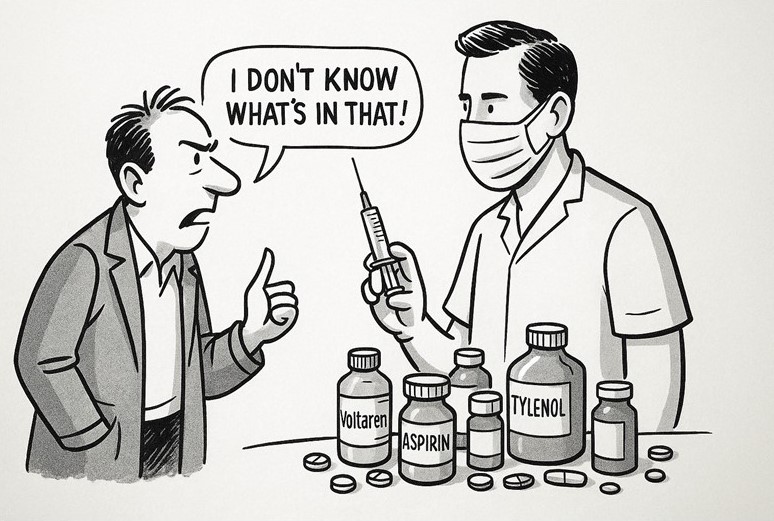

Ogni volta che li mettevo davanti all’evidenza, la conversazione finiva invariabilmente con la stessa frase a effetto:

“Ah sì? Allora dimostrami [provami] che [argomento a piacere] non esiste!”

Oppure, in contesti diversi ma con identica logica capovolta: “Allora dimostrami [provami] che Dio non esiste”.

Chissà perché, ogni volta che ascolto queste argomentazioni, resto colpito dall’involuzione culturale che si sta diffondendo sempre di più. Sono frasi che potevano avere un senso quando ero in terza elementare, quando ci si appellava alla maestra per dirimere questioni vitali come: “Non sono stato io a mettere le mani nella marmellata, è stato lui!”.

Ma in età adulta mi aspetto qualcosa di diverso: argomentazioni più mature, meno retoriche e più legate alla razionalità. E invece questi trucchetti – vecchi come il mondo – continuano a funzionare con chi, pur avendo studiato, non si è abituato al pensiero critico e al metodo scientifico. Il punto è che la scienza, nel bene e nel male, non funziona così.

Provare: ma in che senso?

Ed è proprio qui che nasce la confusione: cosa significa davvero “provare”? Nel linguaggio quotidiano questa parola viene usata in mille modi diversi: provare un vestito, provare a fare una torta, provare un sentimento, provare a convincere qualcuno. E, lasciatemela passare, “provare un esame” – espressione tipica dei miei studenti, che poi però vengono puntualmente bocciati.

Ma in scienza non basta “fare un tentativo” o “avere un’impressione”: qui “provare” significa sottoporre un’idea a un controllo severo, verificare se regge quando viene messa di fronte ai dati.

La Treccani ci ricorda che “provare” significa sia “fare un tentativo” sia “dimostrare con prove la verità di un’affermazione”. Nel linguaggio scientifico, però, prevale il secondo significato: mettere alla prova un’ipotesi. In altre parole, valutare se un’ipotesi spiega davvero i fenomeni osservati e, soprattutto, se permette di fare previsioni verificabili.

Fare scienza significa:

- osservare un fenomeno;

- formulare un’ipotesi che lo spieghi e consenta di fare previsioni;

- progettare esperimenti che possano confermare o smentire l’ipotesi;

- accettare senza sconti il verdetto dei dati.

Se i dati non la confermano, l’ipotesi è falsificata. Punto. In altre parole, non è più utile: non spiega i fenomeni, non regge alla verifica, è semplicemente errata.

L’onere della prova

Rileggiamo l’elenco del paragrafo precedente, partendo dal primo punto:

- osservare un fenomeno.

Qui sta il punto cruciale: se non posso osservare un fenomeno, tutto il resto non ha alcun senso. Come potrei formulare un’ipotesi su qualcosa che non vedo? E se non ho un’ipotesi, come potrei progettare esperimenti? Senza esperimenti non ottengo dati e, senza dati, non posso né confermare né confutare nulla.

In definitiva, se qualcosa non è osservabile, non posso applicare alcun metodo per “provarne” l’inesistenza. La scienza non funziona così: non dimostra l’inesistenza, ma mette alla prova ciò che si afferma di aver osservato. L’onere della prova, quindi, ricade sempre su chi fa l’affermazione, non su chi la mette in dubbio.

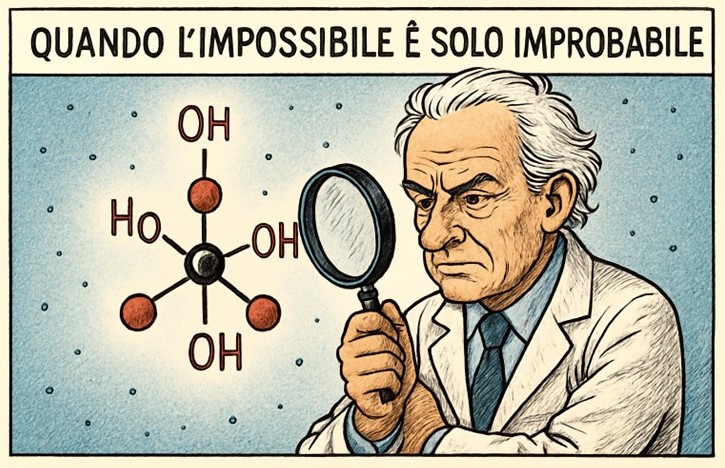

Mettiamola in un altro modo: se ipotizzo che una sostanza chimica acceleri la germinazione dei semi, posso progettare un esperimento. Se i dati non mostrano differenze, l’ipotesi cade. Ma se qualcuno sostiene che “una misteriosa energia invisibile accelera la germinazione solo in certe notti particolari”, senza dire quando, dove e come… beh, quella non è scienza: è una storia che non può essere né verificata né smentita, in altre parole non può essere falsificata.

Ecco perché fantasmi, energie occulte, biodinamica, draghi invisibili o divinità onnipresenti non possono essere oggetto di indagine scientifica: semplicemente non sono ipotesi falsificabili.

Un insegnamento dalla storia

Certo, gli amanti delle scienze occulte (che se sono occulte non sono scienze, ma va bene: usiamo pure l’ossimoro tanto caro ai fan di queste cose) potranno sempre dire: “Ma scusa, come fai a dire che qualcosa non funziona o non esiste se non lo provi? Non è compito dello scienziato verificare, sperimentare e, casomai, proporre o rigettare?”

Sì, certo. Ma solo se – ripeto – il fenomeno è osservabile o se esiste un impianto logico-matematico che consenta di formulare ipotesi verificabili con una progettazione sperimentale precisa.

Facciamo alcuni esempi. L’etere luminifero, ipotizzato come mezzo di propagazione della luce, è stato messo alla prova con esperimenti celebri come quello di Michelson e Morley (1887). I dati hanno detto chiaramente che non c’era nessuna evidenza a suo favore. Lo stesso destino è toccato al flogisto, sostanza immaginaria che avrebbe dovuto spiegare la combustione, spazzata via dalla chimica di Lavoisier.

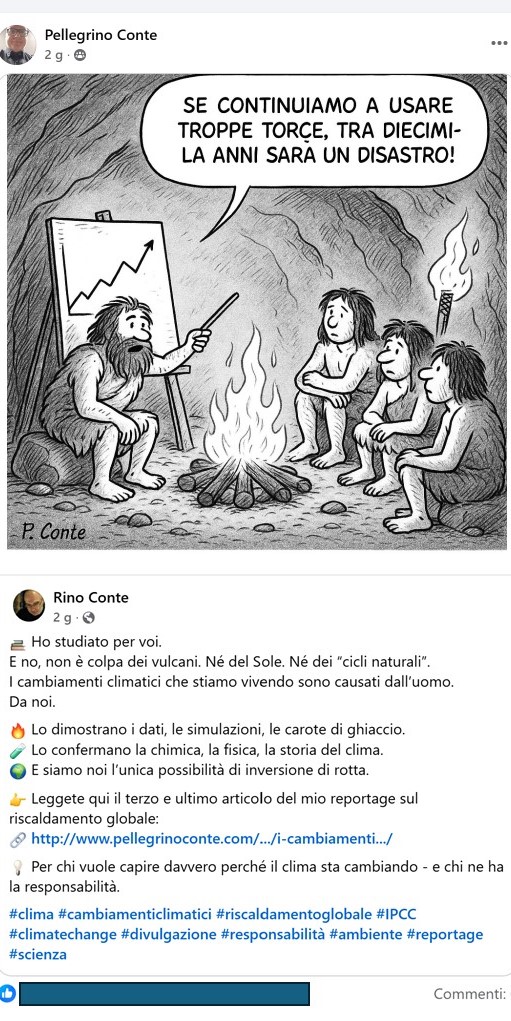

E cosa dire della meccanica classica – sì, proprio quella sviluppata da Isaac Newton – che ha dominato per oltre due secoli e ancora oggi descrive benissimo il mondo macroscopico? All’inizio del Novecento, però, si è mostrata inadeguata a spiegare il comportamento delle particelle microscopiche e i fenomeni a velocità prossime a quella della luce. Da lì sono nate la relatività di Einstein e la meccanica quantistica, due teorie che hanno ampliato il quadro e che, pur con approcci diversi, permettono di fare previsioni in ambiti dove Newton non basta. Eppure, i razzi continuano a essere lanciati nello spazio grazie ai calcoli newtoniani: semplicemente, la sua fisica funziona finché si rimane dentro i suoi limiti di validità.

In tutti questi casi, la scienza non ha “provato l’inesistenza” di etere, flogisto o della validità universale della meccanica classica: ha mostrato che i dati non erano compatibili con quelle ipotesi, oppure che servivano modelli più ampi e predittivi per descrivere meglio la realtà.

La differenza tra scienza e pseudoscienza

Alla luce di tutto quanto scritto finora, si può ribadire con chiarezza che la scienza non fornisce verità eterne: propone modelli coerenti con le prove disponibili, validi finché i dati li confermano. Basta anche un solo dato contrario per metterli in crisi. In quel caso, il modello viene abbandonato oppure ampliato, formulando nuove ipotesi che ne estendano i limiti di validità.

La pseudoscienza, invece, gioca sporco: pretende di invertire l’onere della prova e chiede di dimostrare l’inesistenza dei suoi fantasmi. Non è un caso se, dopo più di due secoli, l’omeopatia è rimasta immobile, sempre uguale a se stessa, senza mai evolversi. O se l’agricoltura biodinamica – nonostante il supporto di figure accademiche che hanno scelto di accreditare l’esoterico come se fosse scienza – non sia mai riuscita a produrre una validazione sperimentale credibile. E l’elenco potrebbe continuare.

Come ammoniva Carl Sagan: affermazioni straordinarie richiedono prove straordinarie. Chi non porta prove, porta solo storie… e spesso nemmeno originali.

Conclusione

No, non si può provare l’inesistenza di qualcosa in senso assoluto. Quello che la scienza può fare, e che fa ogni giorno, è mostrare l’assenza di evidenze e smontare affermazioni che non reggono alla prova dei dati.

Per questo non ha senso chiedere di dimostrare che i fantasmi non infestano le vecchie case, che i preparati biodinamici non funzionano o che Dio non esiste. L’onere della prova spetta sempre a chi afferma, non a chi dubita.

La scienza non è un gioco di prestigio in cui si fanno sparire gli spettri: è un metodo per distinguere ciò che ha basi reali da ciò che resta soltanto una storia.