Negli ultimi anni la biodinamica è tornata con forza nel dibattito pubblico, presentata come un’agricoltura “più naturale”, capace di riconnettere l’uomo con la terra attraverso antichi rituali e influssi cosmici. Ma quando si scava nei lavori scientifici che dovrebbero darle credibilità, il castello crolla.

In un precedente articolo, Agricoltura biodinamica e scienza: il dialogo continua… con i soliti equivoci, avevo già mostrato come l’apparente incontro tra ricerca e pratiche steineriane sia in realtà un dialogo ingannevole. Oggi raccolgo e sintetizzo delle analisi critiche di studi pubblicati su riviste scientifiche, spesso citati a sostegno della biodinamica. Il risultato è un quadro chiaro: tanta tecnologia, poca scienza, e un mare di suggestioni travestite da rigore.

Il mito del Preparato 500

Al centro della biodinamica c’è il Preparato 500, letame fermentato in corna di vacca, elevato a elisir magico. Uno studio del 2013 su Journal of Microbiology and Biotechnology ha tentato di dargli dignità scientifica. Il risultato? Una sequenza di prove deboli: assenza di controlli, attività biologiche senza legame con benefici concreti, repliche non documentate.

Gli stessi autori, del resto, offrono materiale sufficiente per smontare ogni pretesa di scientificità. Non hanno inserito veri controlli: “Different commercial samples of BD Preparation 500… were studied” (p. 645). In pratica, hanno confrontato solo diversi lotti dello stesso preparato, senza mai verificare se i risultati differissero da un letame ordinario.

Le attività enzimatiche riportate sono descritte come promettenti, ma senza legame con effetti pratici: “Preparation 500 displays high specific levels of activity… A high alkaline phosphatase activity indicates its potential” (p. 648). Potenziale, non prova.

Una volta estratto dalle corna, il Preparato viene applicato in campo dopo diluizioni omeopatiche: 200 grammi in decine di litri d’acqua per ettaro. Gli autori non si limitano a descriverne le caratteristiche microbiologiche e chimiche, ma cercano anche di giustificare questa pratica con un ragionamento per analogia: “…they will already be delivered at a 10⁻¹⁰ M concentration… well within their expected windows of biological activity” (p. 649). Ma si tratta di pura speculazione: nessuna prova sperimentale mostra che quelle diluizioni abbiano davvero un effetto.

Il linguaggio stesso tradisce l’incertezza. Ovunque compaiono formule ipotetiche: “could possibly contribute” (p. 648), “may account for the biostimulations” (p. 649), “it cannot be excluded that it might act” (p. 650). Non dimostrazioni, ma tentativi di rivestire di retorica ciò che rimane un rituale agronomico.

Qui la scienza si ferma e subentra il wishful thinking. Non c’è alcun dato che dimostri l’efficacia di quelle diluizioni: è una speculazione posticcia, un tentativo di dare un’aura scientifica a un rituale. In sostanza, la giustificazione proposta non è ricerca: è retorica. Nessun esperimento serio ha mai mostrato che spruzzare tracce infinitesimali di letame fermentato possa produrre effetti concreti su un sistema agricolo complesso.

Corna, letame e spettrometri: la scienza usata per dare lustro al mito

Nel paragrafo precedente è stato introdotto il Preparato 500, gioia degli attivisti della biodinamica. Ebbene, esso è stato analizzato mediante risonanza magnetica nucleare (NMR) e gas-cromatografia con pirolisi (pyrolysis-TMAH-GC-MS) in un lavoro pubblicato su Environmental Science and Pollution Research nel 2012. Questo studio si presenta come la “prima caratterizzazione molecolare” del Preparato 500: una vetrina tecnologica impressionante, che tuttavia poggia su fondamenta fragilissime. Una sfilata di strumenti sofisticati al servizio non della conoscenza, ma della legittimazione di un mito. Vediamo perché.

Gli autori hanno analizzato tre lotti di Preparato 500 (“three samples of horn manure… were collected from different European farms”, p. 2558). Tutto qui. Nessun confronto con compost ordinario o letame tradizionale. Senza un vero controllo, attribuire “peculiarità biodinamiche” diventa arbitrario: come distinguere l’effetto del corno interrato da quello della normale fermentazione del letame?

Le analisi rivelano componenti come lignina, carboidrati, lipidi vegetali e marcatori microbici. Gli stessi autori ammettono che “the chemical composition of HM was consistent with that of natural organic materials” (p. 2564). In altre parole, il Preparato 500 non mostra alcuna unicità sorprendente: è esattamente ciò che ci si aspetta da una biomassa organica parzialmente decomposta.

Il paper suggerisce che la presenza di frazioni labili e lignina parzialmente decomposta possa conferire al Preparato 500 una particolare bioattività: “HM was characterized by a relatively high content of labile compounds that might account for its claimed biostimulant properties” (p. 2565). Ma questa è pura congettura: nessun dato in campo supporta l’idea che tali caratteristiche abbiano effetti agronomici specifici.

Le conclusioni parlano di “a higher bioactivity with respect to mature composts” (p. 2565). Ma il solo risultato tangibile è che il Preparato 500 risulta meno stabilizzato e più ricco di composti facilmente degradabili rispetto a un compost maturo. Un’osservazione banale, trasformata in presunta “prova” di efficacia biodinamica.

In altre parole, il lavoro appena analizzato non dimostra alcuna unicità del Preparato 500. Mostra soltanto che un letame lasciato fermentare in condizioni anossiche dentro un corno ha una composizione chimica simile a quella di altri ammendanti poco maturi. L’uso di strumenti spettroscopici di alto livello serve più a conferire prestigio alla pratica biodinamica che a produrre nuova conoscenza. È un’operazione di maquillage scientifico: dati corretti, ma interpretazione piegata all’ideologia.

Strumenti sofisticati, interpretazioni esoteriche

In uno studio apparso su Chemical and Biological Technologies in Agriculture, gli autori hanno applicato tecniche avanzatissime – MRI (risonanza magnetica per immagini) per la struttura interna delle bacche e HR-MAS NMR per il metaboloma – a uve Fiano e Pallagrello trattate con il celebre Preparato 500. Dal punto di vista tecnico nulla da eccepire: “MRI and HR-MAS NMR provided detailed information on berry structure and metabolite profiles” (p. 3).

Il problema nasce subito dopo. Gli autori collegano direttamente i risultati – “a significant decrease in sugars and an increase in total phenolics and antioxidant activity in biodynamically treated grapes” (p. 5) – all’applicazione del Preparato 500. Ma senza un adeguato controllo placebo questo salto logico è insostenibile: come distinguere l’effetto della “pozione biodinamica” da quello di fattori molto più concreti e plausibili come microclima, esposizione solare, variabilità del suolo o semplici disomogeneità nell’irrigazione?

Gli stessi autori ammettono che la variabilità ambientale è enorme: “soil heterogeneity and microclimatic differences strongly influenced metabolite composition” (p. 6). Eppure, attribuiscono al trattamento biodinamico differenze che potrebbero essere spiegate benissimo da questi fattori.

Ecco il nodo: la biodinamica viene trattata come variabile determinante quando, in realtà, manca la dimostrazione del nesso causale. Si confonde la correlazione con la causa, sostituendo la fatica della verifica sperimentale con il fascino della narrazione esoterica. In altre parole, strumenti scientifici tra i più potenti oggi disponibili vengono usati correttamente per produrre dati robusti, ma poi piegati a interpretazioni che appartengono più al mito che alla scienza. È come se un telescopio di ultima generazione fosse puntato verso il cielo non per studiare le galassie, ma per cercare gli influssi astrali di cui parlano gli oroscopi.

Quando i numeri non tornano

Tra i lavori più citati a sostegno della biodinamica c’è l’articolo di Zaller e Köpke pubblicato su Biology and Fertility of Soils nel 2004, che confronta letame compostato tradizionale e letame compostato con “preparati” biodinamici in un esperimento pluriennale. Sulla carta, il disegno sperimentale sembra solido: rotazioni colturali, repliche, parametri chimici e biologici del suolo.

Ma basta entrare nei dettagli per accorgersi delle crepe. Innanzitutto, gli autori parlano di quattro trattamenti, ma l’unico vero confronto rilevante – biodinamico vs tradizionale – è reso ambiguo dal fatto che manca un controllo cruciale: il letame senza alcuna applicazione (no FYM) è incluso, ma non permette di distinguere se le differenze dipendano dalle preparazioni biodinamiche o, banalmente, dalla sostanza organica. In altre parole, non è possibile stabilire se l’“effetto” sia biodinamico o semplicemente concimante.

In secondo luogo, molte delle differenze riportate sono minime, al limite della significatività statistica, e oscillano addirittura in direzioni opposte tra i diversi strati di suolo (es. la respirazione microbica più bassa con tutti i preparati a 0–10 cm, ma più alta col solo Achillea a 10–20 cm: Fig. 1). Questo non è un segnale di coerenza biologica, ma di rumore sperimentale.

E poi ci sono le rese: tabella 3 mostra chiaramente che le differenze tra preparati e non-preparati non sono mai significative. In pratica, dopo nove anni di sperimentazione, la produttività dei sistemi resta identica, indipendentemente dall’uso o meno dei preparati.

Il colpo finale arriva dall’interpretazione: gli autori ammettono che “how those very low-dose preparations can affect soil processes is still not clear” (p. 228), ma subito dopo ipotizzano meccanismi fumosi come “microbial efficiency” o “stress reduction” senza fornire prove solide. Non sorprende che l’articolo sia diventato un riferimento per i sostenitori della biodinamica: fornisce grafici, tabelle e un lessico tecnico, ma dietro la facciata la sostanza è debole.

In sintesi, questo lavoro non dimostra affatto l’efficacia dei preparati biodinamici: mostra soltanto che il letame fa bene al suolo, una banalità agronomica travestita da scoperta.

Mappatura, non validazione

Giusto per concludere questa breve revisione critica di qualche lavoro sulla biodinamica, prendo in considerazione una review pubblicata su Organic Agriculture che ha analizzato 68 studi sull’agricoltura biodinamica. Gli autori segnalano effetti positivi su suolo e biodiversità, soprattutto in aree temperate, sostenendo che “most studies reported improvements in soil quality parameters, biodiversity, and crop quality under biodynamic management” (p. 3).

Il problema è che si tratta di una rassegna descrittiva, non critica. Gli stessi autori ammettono che “we did not perform a formal quality assessment of the included studies” (p. 2). In altre parole, nessuna valutazione della robustezza metodologica, della significatività statistica o della replicabilità dei risultati. Non hanno fatto, insomma, quello che ho fatto io con le critiche riportate nei paragrafi precedenti.

Non solo: la review mette nello stesso calderone pratiche agricole consolidate (rotazioni, compost, minore uso di chimica) e l’uso dei preparati biodinamici, facendo apparire i benefici come frutto della biodinamica tout court. Un artificio retorico che sposta l’attenzione dall’agronomia alla magia.

Il risultato è esattamente quello che Enrico Bucci definì su Il Foglio una “eterna review”: “un elenco di lavori, non una loro valutazione critica”. Utile come catalogo, ma totalmente inutile come prova di validazione scientifica. Insomma, un inventario ordinato, non una prova di efficacia: la scienza qui rimane alla porta, mentre la retorica magica occupa la scena.

La fatica della demistificazione scientifica

Arrivati a questo punto, vale la pena sottolineare un aspetto che spesso sfugge a chi guarda la scienza dall’esterno. Smontare lavori che si travestono da scienza non è un passatempo da tastiera né un esercizio da poltrona. È un percorso lungo, faticoso e a tratti logorante. Perché?

Per prima cosa bisogna leggere gli articoli nella loro interezza, riga dopo riga, spesso decifrando un linguaggio tecnico volutamente denso. Poi serve una conoscenza approfondita delle metodologie: saper distinguere un NMR da una cromatografia, sapere cosa può misurare davvero un test enzimatico e cosa invece viene gonfiato nell’interpretazione. Infine, è indispensabile una robusta esperienza nella progettazione sperimentale: senza questa non ci si accorge dei bias nascosti, dei controlli mancanti, delle conclusioni che vanno ben oltre i dati.

E tutto ciò richiede tempo, pazienza e un certo spirito combattivo. La scienza procede per tentativi ed errori. Un lavoro pubblicato non necessariamente è valido. La pubblicazione è solo il primo gradino. La vera prova arriva dopo, quando la comunità scientifica lo sottopone a un esame collettivo, minuzioso, implacabile: esperti che “fanno le pulci” a ogni cifra, a ogni tabella, a ogni esperimento. Se il lavoro è solido, resiste e diventa pietra miliare. Se è fragile, si sgretola in fretta e viene dimenticato.

Ecco perché la demistificazione è così importante e così dura: perché si combatte con armi scientifiche contro narrazioni che usano il fascino del mito. E i lavori sulla biodinamica, quando passano sotto questo setaccio, puntualmente crollano.

Conclusione: un fallimento annunciato

Il quadro che emerge è inequivocabile. Studi ben confezionati ma concettualmente vuoti, prove senza controlli, numeri sbagliati, review che confondono agronomia con magia. Tutto ciò che funziona nelle aziende biodinamiche non è esclusivo della biodinamica: è semplice agronomia, già consolidata nel biologico e perfezionata nell’integrato.

Il resto – corna interrate, cicli cosmici, preparati miracolosi – non resiste alla prova della scienza. La biodinamica cerca da oltre un secolo legittimazione, ma ogni volta che la ricerca prova a verificarla seriamente, la sua fragilità diventa evidente. Non è agricoltura del futuro, ma un mito che il tempo ha già smentito.

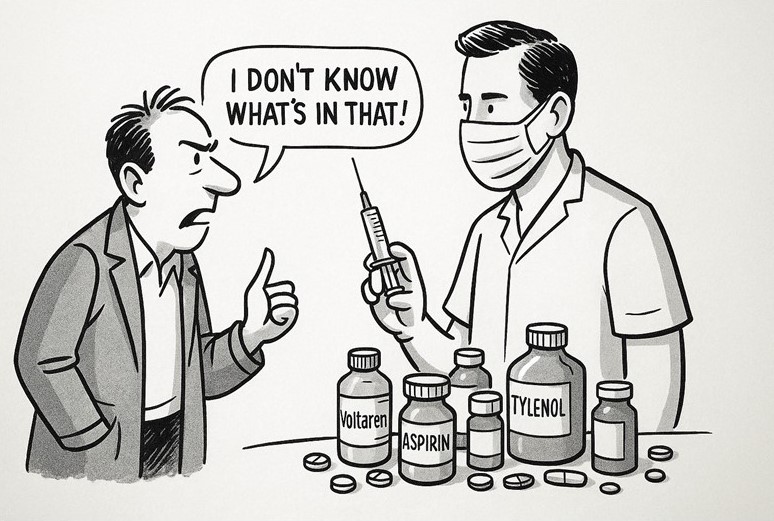

A questo punto, un lettore non addetto potrebbe chiedersi: “Ma se è così fragile, come mai questi studi vengono pubblicati? Possibile che i revisori non se ne accorgano? E come faccio io, dall’esterno, a non fidarmi di ciò che appare su riviste qualificate, persino con un buon Impact Factor?”

La risposta è meno misteriosa di quanto sembri. Come ho già scritto nel paragrafo precedente, la pubblicazione è solo il primo passo: significa che un articolo ha superato un filtro minimo di qualità, non che sia una verità scolpita nel marmo. La peer review non è un tribunale infallibile: è fatta da esseri umani, spesso con tempi stretti e competenze specifiche. Alcuni errori sfuggono, altre volte ci si concentra più sulla tecnica che sulla sostanza. Succede che un lavoro ben scritto e infarcito di strumentazioni sofisticate riesca a passare, anche se le conclusioni sono deboli.

La differenza la fa il tempo e la comunità scientifica. È il vaglio collettivo, fatto di discussioni, repliche, critiche, tentativi di replica sperimentale, che separa ciò che rimane da ciò che evapora. Ed è un processo lento e faticoso, che richiede esperienza, attenzione e anche una certa dose di ostinazione.

Ecco perché non basta fidarsi di un titolo altisonante o di una rivista con un buon IF. Bisogna guardare dentro i lavori, leggerli, pesarli, verificarli. Lo facciamo noi scienziati, ed è una parte del nostro mestiere che non fa notizia, ma è essenziale: distinguere i dati solidi dai castelli di carta.

E ogni volta che la biodinamica entra in questo setaccio, il risultato è lo stesso: crolla.