Ci risiamo! Più volte ho parlato di biodinamica, ma, come sempre accade, questa pratica sembra risorgere dalle ceneri come la fenice, un essere mitologico che ben rappresenta l’impianto fantastico da cui trae origine. Stavolta a riproporla in chiave “scientifica” è un articolo apparso su Terra & Vita l’11 agosto 2025 a firma di Carlo Triarico, presidente dell’Associazione per l’Agricoltura Biodinamica:

? Agricoltura biodinamica e ricerca scientifica, il dialogo continua

Come al solito, ci troviamo di fronte a un testo che cerca di accreditare la biodinamica usando il linguaggio della scienza e richiamando collaborazioni con enti di ricerca. Vale la pena analizzare punto per punto le affermazioni contenute nell’articolo, per capire cosa c’è di sostanza e cosa invece è pura retorica.

La premessa retorica

“La crisi ambientale impone nuove pratiche rigenerative, accompagnate da un solido impianto di validazione scientifica.”

Che la crisi ambientale e climatica sia una realtà innegabile è fuori discussione. Nessuno scienziato serio la nega. Ma proprio perché la crisi è reale, il richiamo a essa non può essere usato come cavallo di Troia per giustificare qualunque pratica, tanto meno quelle nate da premesse esoteriche. È un classico espediente retorico: evocare un problema grave e condiviso per darsi legittimità, senza però dimostrare che la soluzione proposta sia davvero efficace.

Il termine “pratiche rigenerative” è suggestivo ma vago. Rigenerare cosa? In che modo? Con quali meccanismi verificabili? Senza una definizione chiara, si resta nell’ambito dello slogan. La biodinamica viene così presentata come medicina miracolosa, ma senza che siano forniti protocolli scientifici in grado di dimostrare causalità tra pratiche e risultati.

Infine, parlare di “validazione scientifica” è improprio. La scienza non “valida” come fosse un ente certificatore che mette bollini di approvazione. La scienza funziona per ipotesi sottoposte a prove, dati che devono essere replicabili, esperimenti che altri ricercatori possono confermare o smentire. Se un modello agronomico ha basi solide, non c’è bisogno di rivestirlo di retorica: i dati parlano da soli.

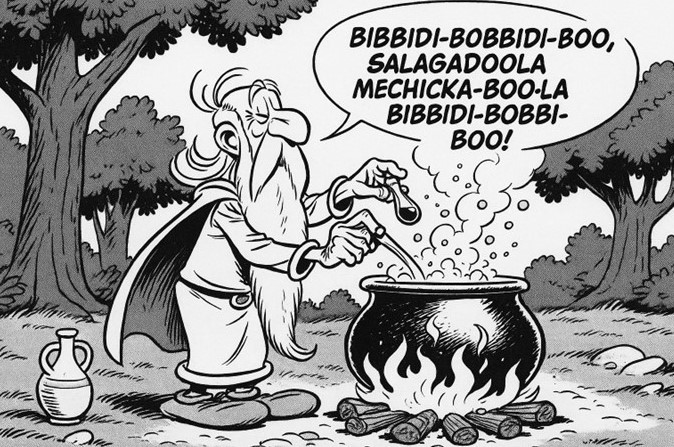

La verità è che quando si tratta di biodinamica, si invoca la scienza come un orpello decorativo, ma si evita accuratamente di sottoporre al vaglio critico proprio i capisaldi del metodo — i preparati, le diluizioni omeopatiche, i cicli cosmici. Su questi aspetti, che costituiscono l’anima della biodinamica, non esiste alcuna evidenza.

In altre parole: usare la crisi climatica come giustificazione per promuovere pratiche prive di fondamento non è un’operazione scientifica, ma retorica.

La “visione sistemica”

“La biodinamica, con la sua visione sistemica e la cura della terra, ha molto da offrire in termini di sostenibilità.”

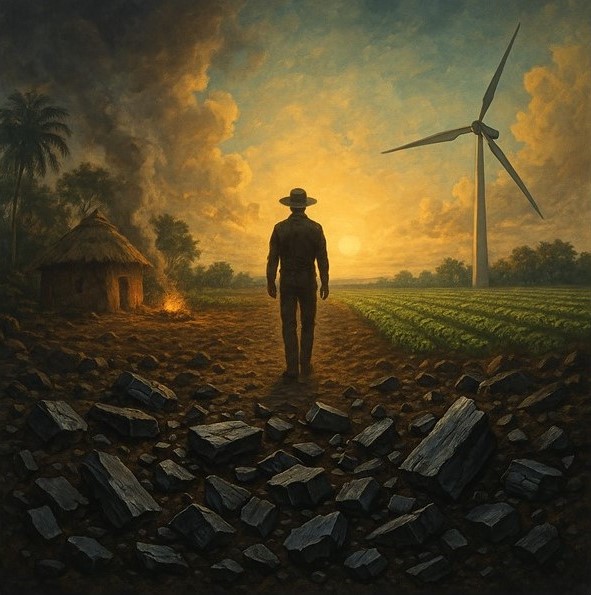

“Visione sistemica” è un’espressione ad alto impatto emotivo, che sembra evocare profondità e modernità di pensiero. Ma è un concetto che, applicato così, resta puramente decorativo. In agronomia la gestione integrata dei sistemi agricoli è già una realtà da decenni: rotazioni colturali, pratiche conservative, uso oculato delle risorse idriche, incremento della sostanza organica del suolo. Tutti questi approcci rientrano già da tempo nell’agricoltura biologica, nella lotta integrata e nei sistemi sostenibili, senza bisogno di ricorrere a cosmologie esoteriche.

Attribuire alla biodinamica una presunta “visione sistemica” è dunque un’operazione di maquillage: si prende un concetto scientificamente serio, lo si ammanta di suggestioni e lo si appiccica a pratiche che con la scienza hanno poco a che fare. In realtà, la biodinamica non porta alcuna innovazione metodologica: si limita a riproporre tecniche già note in agricoltura ecocompatibile, aggiungendo però un corredo rituale che nulla aggiunge né alla produttività né alla sostenibilità.

È come se qualcuno prendesse l’omeopatia e la presentasse come “medicina olistica sistemica”: un modo elegante per mascherare l’assenza di meccanismi verificabili dietro un linguaggio affascinante. Allo stesso modo, dire che la biodinamica ha “molto da offrire” in termini di sostenibilità è fuorviante: ciò che funziona non è la biodinamica, ma le stesse pratiche agronomiche già validate che essa incorpora al suo interno.

In sintesi, la “visione sistemica” non è un portato della biodinamica: è un concetto scientifico e agronomico che le viene arbitrariamente attribuito per conferirle un’aura di credibilità.

Le collaborazioni scientifiche

“Abbiamo collaborato con CREA, Università di Firenze, Università di Salerno, CERMANU, SISB…”

E qui scatta il gioco delle citazioni, un artificio retorico ben collaudato: nominare enti di ricerca e università serve a costruire una patina di autorevolezza, come se la sola menzione bastasse a trasferire credibilità scientifica. Ma la realtà è più complessa.

Che università e centri di ricerca abbiano svolto studi sulla fertilità del suolo, sulla biodiversità o sull’impatto ambientale delle pratiche agricole è un dato di fatto. Questo, però, non equivale ad aver avallato i principi fondanti della biodinamica, che restano di natura esoterica. Bisogna distinguere nettamente:

- quando si studiano pratiche agronomiche comuni, come la riduzione dei fertilizzanti di sintesi (cioè sistemi inorganici), l’incremento della sostanza organica o la gestione integrata del terreno, si sta facendo agronomia.

- quando invece si invocano corna di vacca interrate, preparati dinamizzati in acqua agitata ritualmente, o influssi cosmici legati alla posizione della Luna, si entra nell’ambito del rituale, non della ricerca scientifica.

Mescolare i due livelli, come avviene sistematicamente nei comunicati del mondo biodinamico, è un’operazione retorica: si confonde il rigore della scienza con il linguaggio mistico, sperando che la rispettabilità della prima copra le fragilità della seconda.

In altre parole: se un’università conduce uno studio sulla biodiversità in un’azienda biodinamica, il dato che ottiene riguarda la biodiversità in quell’azienda, non la validazione delle teorie di Steiner. Dire il contrario equivale a dire che se un medico misura la pressione a un paziente che porta un amuleto al collo, allora lo studio conferma l’efficacia dell’amuleto.

Il problema, dunque, non è la collaborazione in sé, ma il suo uso strumentale: un modo per presentare come “scientificamente supportato” ciò che resta, nei suoi fondamenti, privo di basi scientifiche.

L’azienda modello e la certificazione Demeter

“Le aziende certificate Demeter come Lacalamita Rosa mostrano risultati significativi e attraggono nuovi produttori.”

Portare ad esempio aziende di successo è una strategia comunicativa potente: un nome evocativo, qualche dato positivo e il lettore medio è portato a pensare che il merito sia tutto della biodinamica. Ma il ragionamento è fuorviante.

Il successo commerciale o l’apprezzamento dei consumatori non dimostrano di per sé la validità scientifica di un metodo. Un’azienda può prosperare per molte ragioni: la qualità intrinseca del suolo, la competenza agronomica di chi la conduce, le condizioni climatiche favorevoli, oppure semplicemente un buon posizionamento di mercato. Attribuire automaticamente questi risultati alla biodinamica equivale a confondere i fattori: è il tipico errore di scambiare correlazione per causalità.

Quanto alla certificazione Demeter, non si tratta di un riconoscimento indipendente né neutrale. È un marchio privato, gestito dal movimento biodinamico stesso, che valuta la conformità delle aziende a un disciplinare interno. E questo disciplinare, lungi dall’essere scientifico, prescrive pratiche rituali che includono i famosi preparati e le procedure esoteriche steineriane. Parlare quindi di “standard oggettivi” è improprio: non si tratta di oggettività scientifica, ma di coerenza con un regolamento autoreferenziale.

Per chiarire con un paragone: dire che un’azienda è “validata scientificamente” perché certificata Demeter è come dire che un club di astrologi garantisce l’accuratezza dell’oroscopo dei suoi membri. Vale come appartenenza a una comunità che condivide gli stessi rituali, ma non come dimostrazione di efficacia.

In definitiva, l’esempio delle aziende modello e della certificazione Demeter serve a costruire un racconto accattivante, ma non sposta di un millimetro la questione centrale: i principi fondanti della biodinamica restano privi di fondamento scientifico.

Lo studio con NMR sull’uva da tavola

“Gli studi con spettroscopia H-NMR hanno mostrato parametri qualitativi superiori nell’azienda biodinamica.”

Qui si tocca un aspetto che, letto in fretta, sembra confermare in pieno la narrazione biodinamica: un’analisi sofisticata, condotta con uno strumento scientifico avanzato, avrebbe mostrato differenze qualitative a favore dell’azienda biodinamica. Ma la realtà, ancora una volta, è diversa.

Innanzitutto, va chiarito cosa significhi “parametri qualitativi superiori”. Una differenza nei profili metabolomici non equivale automaticamente a un miglioramento. In metabolomica, infatti, i dati descrivono variazioni nella concentrazione di certi composti, ma la loro interpretazione dipende dal contesto e da ulteriori correlazioni con parametri sensoriali, nutrizionali o tecnologici. Dire che un prodotto è “migliore” perché diverso non ha alcun senso scientifico.

In secondo luogo, anche ammesso che un’azienda biodinamica mostri parametri più favorevoli, ciò non dimostra affatto che la causa sia la biodinamica in sé. Gli studi comparativi, per essere robusti, devono isolare le variabili: stesse condizioni pedoclimatiche, stesso vitigno, stessa gestione agronomica, stesso livello di esperienza dell’agricoltore. Nella realtà, però, un’azienda non è un laboratorio sterile: il suolo, il microclima, l’età delle piante, persino la cura quotidiana nella gestione possono influenzare i risultati.

Attribuire quindi le differenze osservate ai preparati steineriani o all’influenza dei cicli cosmici è un salto logico arbitrario. Sarebbe come dire che, se una squadra di calcio vince una partita, il merito è della maglia portafortuna indossata dall’allenatore. Correlazione e causalità, ancora una volta, vengono confuse deliberatamente.

Infine, l’uso stesso di tecniche avanzate come la spettroscopia NMR rischia di funzionare da “effetto scenico”: uno strumento complesso viene chiamato in causa per impressionare il lettore, non per fornire prove decisive. Ma la scienza non si misura dalla sofisticazione dello strumento, bensì dalla solidità del disegno sperimentale e dalla replicabilità dei risultati.

In sintesi: se anche uno studio rileva differenze, non è corretto attribuirle tout court alla biodinamica. La vera prova mancherebbe proprio là dove servirebbe: dimostrare che i precetti esoterici abbiano un effetto misurabile e riproducibile. E questa prova, ad oggi, non esiste.

Agroecologia e dieta mediterranea

“La biodinamica si integra con i principi dell’agroecologia e della Dieta Mediterranea sostenibile.”

Questo passaggio è un esempio chiaro di appropriazione semantica: si accostano concetti scientificamente fondati (agroecologia e Dieta Mediterranea) a un paradigma privo di basi razionali come la biodinamica, nel tentativo di trasferire prestigio dall’uno all’altro.

L’agroecologia è un approccio interdisciplinare che combina scienze agrarie, ecologia, economia e sociologia per rendere sostenibili i sistemi agricoli. La Dieta Mediterranea, invece, non è affatto un modello antico e immutato: è una costruzione recente, nata negli Stati Uniti negli anni ’50-’60 grazie agli studi di Ancel Keys, che osservò la maggiore longevità di alcune popolazioni del bacino mediterraneo. Da quelle osservazioni derivò un modello alimentare “idealizzato”, promosso poi a livello internazionale. Nonostante le sue origini moderne e in parte commerciali, la Dieta Mediterranea si è guadagnata un solido supporto scientifico: numerosi studi hanno confermato la correlazione con benefici per la salute, e l’UNESCO l’ha riconosciuta come patrimonio culturale immateriale per il suo valore sociale e culturale.

La biodinamica, al contrario, nasce da premesse esoteriche di Rudolf Steiner e non ha alcuna validazione scientifica. Metterla sullo stesso piano dell’agroecologia e della Dieta Mediterranea è quindi fuorviante: mentre le prime si fondano su dati, osservazioni e modelli riproducibili, la biodinamica resta ancorata a rituali cosmici e pratiche prive di riscontro sperimentale.

Il meccanismo comunicativo è evidente: evocare concetti positivi e consolidati per “nobilitare” la biodinamica. Ma, in realtà, tutto ciò che appare compatibile con l’agroecologia o con il modello mediterraneo (rotazioni, compostaggio, riduzione degli input chimici) non è esclusivamente biodinamico: appartiene già all’agricoltura biologica e sostenibile. L’unico elemento davvero caratterizzante della biodinamica — i preparati e i rituali steineriani — non ha alcun fondamento scientifico.

In definitiva, questo accostamento non rafforza la biodinamica: ne evidenzia piuttosto la debolezza, perché dimostra il suo costante bisogno di appoggiarsi ad altro per sembrare credibile.

Standard e protocolli “oggettivi”

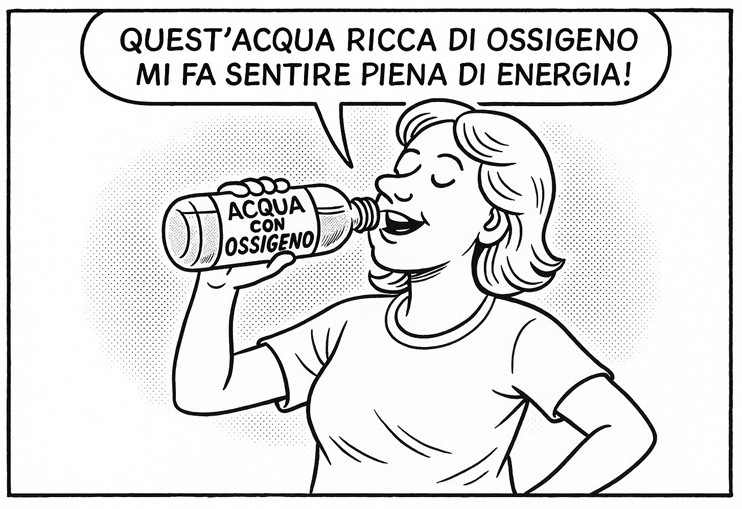

“La biodinamica è identificata da standard e protocolli oggettivi e soggetti a verifica.”

Questa affermazione suona rassicurante, ma è profondamente ambigua. Nel linguaggio della scienza, “standard oggettivi” significa procedure condivise, ripetibili, verificabili da chiunque e soprattutto indipendenti da appartenenze ideologiche. Nel caso della biodinamica, invece, gli “standard” non sono altro che le regole fissate dal marchio Demeter, ovvero dall’organizzazione stessa che promuove la biodinamica.

Questi protocolli prevedono sì pratiche agronomiche comuni e sensate (rotazioni, compostaggio, attenzione alla fertilità del suolo), ma includono anche prescrizioni rituali come i preparati dinamizzati o le corna interrate seguendo cicli lunari e planetari. Non c’è nulla di scientifico in questo: sono norme interne a una comunità, autoreferenziali, che si verificano in base alla loro stessa coerenza interna, non sulla base di prove oggettive.

È come dire che l’astrologia è “oggettiva” perché esistono regole precise per calcolare un oroscopo. Certo, il calcolo segue un protocollo, ma ciò non significa che il risultato abbia validità scientifica. Allo stesso modo, rispettare il disciplinare Demeter dimostra solo che un’azienda aderisce a un regolamento, non che i principi steineriani abbiano efficacia reale.

Il vero paradosso è che il richiamo alla “verifica” finisce per essere un gioco di specchi: chi controlla la conformità non valuta i risultati scientifici delle pratiche, ma solo la fedeltà a un rituale codificato. È un sistema chiuso, che si autolegittima senza mai confrontarsi con il metodo scientifico.

In sintesi: parlare di “protocolli oggettivi” in biodinamica è un abuso del linguaggio scientifico. Non si tratta di oggettività, ma di appartenenza. Non si tratta di verifiche, ma di rituali. E questa differenza non è un dettaglio semantico: è il punto che segna la distanza tra scienza e pseudoscienza.

Conclusione

Ancora una volta la biodinamica si presenta con abiti nuovi, evocando crisi ambientali, citando enti di ricerca, richiamando agroecologia e dieta mediterranea, esibendo certificazioni e dati metabolomici. Ma al di là della patina, la sostanza resta immutata: i capisaldi steineriani non hanno alcuna validazione scientifica.

Tutto ciò che funziona nelle aziende biodinamiche non è esclusivo della biodinamica: è semplice agronomia, già consolidata nel biologico e perfezionata oggi nell’agricoltura integrata. La differenza è che qui si parla di conoscenze scientifiche, non di rituali esoterici. Ciò che resta tipicamente biodinamico non ha alcuna evidenza e non può essere considerato scienza.

La conclusione è inevitabile: la biodinamica non rappresenta un modello innovativo di sostenibilità, ma un insieme di pratiche esoteriche rivestite di retorica scientifica. E confondere scienza e rituale non aiuta l’agricoltura a diventare più sostenibile: la espone, semmai, al rischio di perdere credibilità proprio quando la società ha più bisogno di rigore, trasparenza e soluzioni reali.

Come la fenice, la biodinamica sembra risorgere dalle proprie ceneri: ma, a differenza del mito, dalle sue ceneri non nasce mai scienza.