INTRODUZIONE AGLI OGM

Il tema degli OGM per le biodiversità e il pericolo che rappresentano è un cavallo di battaglia per i sostenitori anti-OGM. La loro idea è che gli organismi modificati geneticamente riducano la biodiversità degli ecosistemi con conseguente danni ecologici non più risanabili. Infatti, è ben noto che i vari comparti ambientali (residenza di forme di vita diversificate) siano risorse non rinnovabili, per cui i danni ad essi apportati si tradurrebbero nella perdita delle proprietà atte al sostentamento della vita. Questa argomentazione è ampiamente documentata in tantissimi siti web. Basta, infatti, ricercare in Google “OGM per le biodiversità” per venire inondati da centinaia, se non migliaia, di siti anti-OGM.

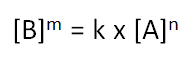

Nel mondo attuale in cui predomina la falsa idea della democraticità della scienza, ne viene che un utente medio (ovvero dalla cultura scientifica non troppo sviluppata) possa pensare che, se tanti, troppi, siti web dichiarano che gli OGM per le biodiversità siano pericolosi, questo sia un fatto reale e che la posizione pro-OGM da parte del mondo scientifico nasconda chissà quali trame oscure. Prevale, insomma, l’idea che il rumore di fondo sia paragonabile ed abbia la stessa rilevanza dei segnali, neanche molto sporadici, che si alzano ben al di sopra di tale rumore.

Cerchiamo di fare, invece, chiarezza per quanto possibile e vediamo di affrontare il problema nel modo più oggettivo possibile.

Affrontare un problema in modo oggettivo vuol dire applicare il metodo scientifico e cominciare, innanzitutto, a definire i contorni entro i quali ci si muove. Per delimitare i contorni anzidetti bisogna capire ciò di cui si parla.

COSA VUOL DIRE COMPARTO AMBIENTALE

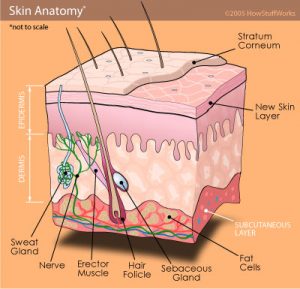

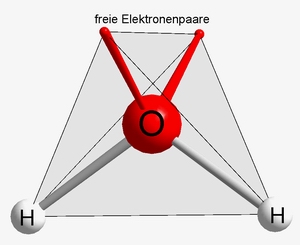

È ben noto che l’acqua è un bene indispensabile del quale nessun organismo vivente può fare a meno. È il mezzo che consente la veicolazione dei nutrienti ed è il solvente nel quale si completano tutte le reazioni chimiche che caratterizzano il metabolismo sia animale che vegetale. Contaminare le acque vuol dire renderle inadatte al metabolismo come esso si è sviluppato nel corso degli eoni [1].

Una argomentazione analoga va invocata per il suolo. Anche se meno intuitivamente, il suolo va protetto esattamente come le acque. Dal momento che esso è la sede per la produzione alimentare ed è fonte del nostro nutrimento (sembra strano doverlo dire, ma i prodotti che si comprano al supermercato non crescono sui banconi degli stessi), contaminare un suolo o (più in generale) depauperarlo delle proprietà che lo caratterizzano, vuol dire ridurre drasticamente l’approvvigionamento alimentare in grado di sostenere tutte le forme animali e vegetali che popolano il nostro pianeta [1].

Anche l’atmosfera ha una importanza fondamentale nel sostenere la vita. È ben noto, infatti, che, grazie alla particolare miscela dei vari gas che la compongono, tutti gli organismi viventi sono in grado di esplicare le proprie funzioni. Rimanendo solo nell’ambito umano, una composizione atmosferica solo in minima parte diversa da quella che conosciamo (ovvero all’incirca 20% di ossigeno molecolare, 79% di azoto molecolare e 1% di altre tipologie di gas) non consentirebbe la nostra sopravvivenza. Infatti, al di sotto del 16% circa di ossigeno molecolare atmosferico moriremmo per asfissia, mentre concentrazioni molto elevate di ossigeno molecolare atmosferico comporterebbero la distruzione delle cellule secondo meccanismi che non sto a descrivere perché al di là degli scopi di questo semplice articoletto [1].

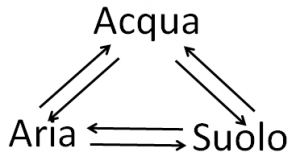

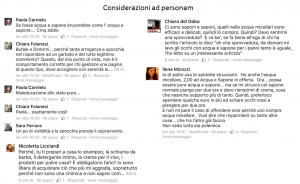

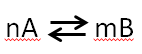

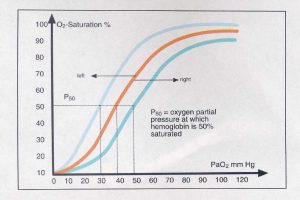

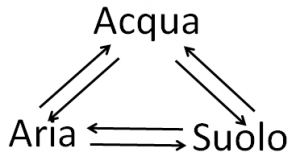

I tre sistemi citati, ovvero acque, suoli ed atmosfera (tralascio per semplicità il quarto che è quello dei sedimenti), sono tutti indispensabili al sostentamento della vita come noi la conosciamo e rappresentano tre comparti distinti dell’ambiente in cui viviamo. Pur essendo distinti per la loro natura chimica, essi non sono indipendenti gli uni dagli altri, ma sono interconnessi secondo uno schema semplificato del tipo:

In altre parole, gli equilibri chimici alla base dello sviluppo di uno dei tre comparti influenzano tutti gli altri. Questo vuol dire che un contaminante immesso in atmosfera dall’attività antropica può ricadere al suolo attraverso le piogge; dal suolo può raggiungere le acque di falda mediante lisciviazione; da queste, infine, può arrivare ai fiumi ed al mare. Durante tutto questo percorso, il contaminante può entrare a contatto con la biosfera, ed in particolare con l’uomo, attraverso la catena alimentare con conseguenze più o meno drammatiche a seconda del livello di tossicità del contaminante stesso [1].

COSA VUOL DIRE RISORSA NON RINNOVABILE

In termini ambientali, una “risorsa” è una qualsiasi fonte o un qualsiasi mezzo atto al sostentamento della vita [1, 2]. Alla luce di questa definizione, si può dire che i comparti ambientali descritti nel paragrafo precedente sono utili “risorse” per tutti gli esseri viventi. Non è difficile intuire, infatti, che senza aria e senza acqua non potrebbe esistere la vita come noi la conosciamo, così come senza suolo non sarebbe possibile alcuna produzione alimentare.

Sfruttare le risorse per il sostentamento della vita vuol dire usarle, da un lato, per migliorare la qualità dell’esistenza (per esempio, producendo l’energia necessaria per muoversi verso l’agognato luogo delle meritate vacanze), dall’altro, per produrre gli alimenti che servono per sopravvivere (in modo da poter lavorare e guadagnare abbastanza per poter andare nei luoghi vacanzieri anzidetti). In ogni caso, lo sfruttamento delle risorse ambientali comporta il consumo delle stesse con riduzione progressiva delle capacità di sostenere la vita. Per esempio, usare acqua dolce nella lavatrice sottrae questa risorsa all’alimentazione; coltivare i campi per produrre alimenti diminuisce la qualità dei suoli (laddove il concetto di qualità è di tipo positivo dal momento che ci si riferisce ad un insieme di proprietà che consentono l’utilizzo dei suoli ai fini della produzione alimentare).

Il significato di “rinnovabile” si riconduce alla capacità della risorsa utilizzata (e, di conseguenza, consumata) di rigenerarsi in modo da consentirne un uso costante nel tempo [1, 2]. Questa visione di “rinnovabile”, tuttavia, è troppo generica perché non tiene conto del fatto che tutti i comparti ambientali sono rinnovabili su scale temporali che vanno molto oltre il tempo di vita medio degli esseri umani.

Perché una risorsa possa essere considerata “rinnovabile” e, quindi, utile al sostentamento della vita, è necessario che il tempo necessario per la sua rigenerazione sia almeno confrontabile con quello medio della vita umana. Per questo motivo, si può affermare che i comparti ambientali anzidetti, in grado di rigenerarsi in tempi molto più lunghi della vita media umana, sono delle risorse non rinnovabili.

COSA E’ LA SOSTENIBILITA’?

“Sostenibilità” è un termine usato a livello scientifico con diversi significati a seconda del contesto in cui viene usato. In particolare, in campo agricolo, “sostenibilità” si riferisce alla capacità di un sistema a mantenere la propria produttività costante, indipendentemente dal grado di alterazione a cui il sistema stesso è sottoposto [2]. Detto ciò, si può intuire che l’attività agricola in toto, ovvero anche quella ritenuta a impatto nullo come l’agricoltura biologica, ha un forte effetto sui suoli e sui diversi comparti ambientali. La lavorazione meccanica dei suoli, per esempio, se da un lato ne migliora l’ossigenazione e la strutturazione, dall’altro li rende più facilmente erodibili; le piante che assumono nutrienti durante le diverse fasi della germinazione e della crescita li sottraggono al suolo diminuendone, così, la fertilità se tali nutrienti non vengono opportunamente restituiti al suolo mediante fertilizzazione; l’irrigazione, necessaria per consentire la produzione vegetale, sottrae acqua potabile necessaria alla sopravvivenza umana; l’attività zootecnica oltre a sfruttare suolo (per la costruzione delle stalle e l’approvvigionamento alimentare degli animali) è associata anche alla contaminazione atmosferica in quanto gli animali producono gas serra; e potrei continuare. La conservazione delle risorse non rinnovabili passa necessariamente attraverso l’uso di pratiche agricole sostenibili quali, per esempio, quelle che limitano l’uso massivo di fertilizzanti inorganici favorendo l’applicazione di fertilizzanti organici; l’uso di tecniche colturali che limitano la produzione di gas serra (per esempio il minimum tillage e la semina diretta su terreno non lavorato) o il consumo di acqua potabile (per esempio la pacciamatura); la gestione integrata del suolo attraverso la lotta alla desertificazione e la corretta gestione dei suoli destinati sia alla produzione alimentare che energetica [3-5].

COSA SIGNIFICA BIODIVERSITÀ

L’enciclopedia Treccani definisce la biodiversità come “la variabilità tra gli organismi viventi all’interno di una singola specie, fra specie diverse e tra ecosistemi”. In effetti il termine “biodiversità”, di cui tanti oggi abusano, è molto complesso e per spiegarlo provo ad usare delle metafore.

Immaginiamo un condominio in un palazzo di 5 piani (sistema A) con due appartamenti per piano; ogni singolo appartamento può essere considerato come un piccolo ecosistema autonomo. Gli abitanti di ogni appartamento rappresentano la biodiversità dell’ecosistema/appartamento. Essi dormono, si svegliano, fanno colazione, pranzano, cenano e comprano tutto ciò di cui hanno bisogno. Un giorno il singolo proprietario di un appartamento che vive da solo nel suo ecosistema/bilocale, decide di fare un dolce ma si accorge di aver finito lo zucchero ed è troppo tardi per trovare un negozio aperto. Cosa fa? Esce dal proprio ecosistema/appartamento e suona all’ecosistema/appartamento vicino. Quest’ultimo è un ecosistema/quadrilocale in cui possono vivere comodamente 4 persone. La biodiversità dell’ecosistema/bilocale è inferiore in termini numerici rispetto a quella dell’ecosistema/quadrilocale. La maggiore disponibilità di spazio consente una maggiore biodiversità. Tuttavia, i due ecosistemi autonomi interagiscono tra loro quando è necessario per permettere la sopravvivenza (nel nostro caso mediante lo scambio di zucchero) degli organismi viventi che lo occupano (potremmo dire che occupano le due diverse nicchie ecologiche).

Una volta evidenziato che gli organismi viventi possono sopravvivere grazie alla interazione tra gli ecosistemi confinanti, andiamo oltre.

Il numero di componenti medio negli ecosistemi/appartamento è, diciamo, 4; ne viene che la popolazione del condominio è di 40 persone.

Cambiamo scenario.

Consideriamo lo stesso numero medio di persone per appartamento ma in un condominio di un palazzo di 10 piani (sistema B). Il numero totale di persone in questo nuovo sistema è 80. Possiamo dire che la biodiversità (intesa come numero di persone) del sistema B è maggiore di quella del sistema A. Supponiamo ora che i due palazzi (ovvero sistema A e sistema B) siano costruiti in uno spazio in cui sia presente un termitaio (sistema C). Il termitaio è abitato da, diciamo, 10000 termiti. Possiamo dire che la biodiversità (sempre intesa come numero di individui per ogni sistema) varia nell’ordine sistema C > sistema B > sistema A. Tuttavia, la popolazione dei sistemi A e B è fatta da persone appartenenti alla stessa specie, ovvero umani (indichiamoli come sistema U, per semplicità), per cui possiamo dire che la biodiversità del termitaio è di gran lunga maggiore di quella degli umani nei due condomini appena citati, ovvero sistema C > sistema U. Facciamo, ora, un passo avanti e assumiamo che nel terreno dove sorgono i condomini ed il termitaio ci sia anche un fiume (sistema D) in cui mediamente vivono non meno di 500 pesci. Possiamo dire che la biodiversità (ancora intesa come numero di individui diversi) nei due ecosistemi suolo e acqua varia come sistema C > sistema D > sistema U. Tuttavia, se raggruppiamo i sistemi C ed U in base al fatto che sono entrambi terrestri (indichiamo i due messi insieme come sistema T), ne viene che sistema T > sistema D. Ma nel fiume, così come sulla terra, non “abitano” soltanto pesci o termiti o umani. Ci sono anche piante, uccelli, insetti, e altre moltitudini di micro, meso e macro organismi. È l’insieme di tutti questi esseri viventi, in grado di interagire tra loro con modalità differenti (per esempio in modo simbiotico o parassitario), a costituire la biodiversità [6].

L’esempio fatto evidenzia che la biodiversità si riferisce non solo alle specie viventi in un dato ecosistema, ma anche alla diversificazione degli ecosistemi stessi che sono in grado di interagire simbioticamente, e quindi sopravvivere, grazie alle interazioni tra loro.

L’importanza della biodiversità risiede nel fatto che viene assicurato l’equilibrio dinamico della biosfera [7]. In particolare, maggiore è la biodiversità e maggiore è la probabilità che venga assicurata la continuità della vita nel caso in cui alterazioni ambientali sconvolgano gli ecosistemi [7]. In altre parole, se l’impatto di un meteorite sulla Terra comporta l’estinzione di una certa specie (come i dinosauri), la nicchia ecologica lasciata libera dalla specie estinta viene occupata da altre forme di vita e la vita, in senso generale, è, in ogni caso, in grado di continuare [7]

AGRICOLTURA E BIODIVERSITÀ

Alla luce di quanto detto fino ad ora è lecito chiedersi quale sia il ruolo dell’agricoltura in tutte le sue forme nello sviluppo della biodiversità.

È stato già evidenziato che tutte le pratiche agricole hanno un forte impatto sui diversi comparti ambientali alterandone le caratteristiche e rendendoli inadatti al sostentamento della vita se non vengono applicate opportune regole per la conservazione degli stessi [3-5]. Nella fattispecie, l’attività agricola necessita di ampi spazi nei quali poter coltivare le piante ad uso alimentare. I grandi spazi si ottengono solo attraverso il disboscamento. La semplice conversione di uno spazio da foresta a campo agricolo comporta non solo un aumento netto di anidride carbonica [1], ovvero un gas serra, nell’atmosfera (quindi incremento dell’inquinamento del comparto aria), ma anche un cambiamento nella tipologia di micro, meso e macro fauna che è in grado di sopravvivere in quel luogo [1]. Faccio un esempio molto semplice.

In un bosco vivono i gufi; se viene attuato il disboscamento per convertire il bosco in spazio arabile, si elimina l’habitat dei gufi che, di conseguenza, spariscono da quell’area. Al posto dei gufi subentrerà un’altra tipologia di uccelli, per esempio i corvi, che sopravvivono “predando” le colture che gli umani usano per la loro produzione alimentare. I gufi sono predatori naturali di topi ed altri piccoli animali. Questi ultimi, in assenza dei loro predatori, tenderanno a proliferare incrementando il loro numero. Come si arguisce da questo esempio banale, la conversione di uno spazio da bosco a campo agricolo comporta la sparizione di un certo tipo di esseri viventi e la comparsa di altri animali più adatti a vivere nel nuovo ambiente.

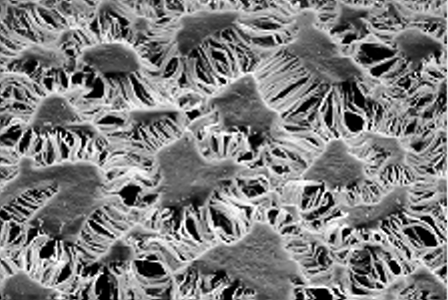

Il discorso che ho fatto sui gufi, i corvi ed i topi si applica anche alla biomassa microbica dei suoli che, come gli animali anzidetti, contribuisce alla biodiversità del sistema agricolo. Tutto questo, naturalmente, è valido se guardiamo solo alla fauna. Se guardiamo alle specie vegetali, l’attività agricola (e, si badi bene, sto parlando di tutte le tipologie di agricoltura) comporta una drastica riduzione della biodiversità vegetale. Infatti le aree boschive sono molto ricche di specie vegetali di ogni tipo, in grado di vivere in simbiosi tra loro o parassitando altre specie vegetali. Se vogliamo produrre mega litri di olio extra vergine di oliva dalla varietà Biancolilla da esportare in tutto il mondo abbiamo bisogno solo di ulivi che appartengono alla cultivar che ci interessa. La massimizzazione della produzione, inoltre, comporta la necessità di eliminare tutte le piante “parassite” in grado di competere con quelle di interesse per l’assorbimento dei nutrienti.

In altre parole, l’attività agricola comporta una alterazione della biodiversità faunistica (micro, meso e macro) nel senso che ad una diminuzione del numero di specie viventi rispetto a quelle presenti nelle zone vergini corrisponde anche la colonizzazione del nuovo habitat da parte di altre specie adatte alla sopravvivenza negli spazi destinati all’agricoltura. Per altri versi, sotto il profilo della biodiversità vegetale, le monocolture sostituiscono l’enorme varietà biologica che caratterizza le aree boschive/forestali.

Da tutto quanto detto si capisce che è possibile distinguere tra biodiversità forestale/boschiva e biodiversità agricola (in questa sede tralascio gli altri tipi di biodiversità come quella aerea e acquatica che sono fuori contesto). La prima riceve un rapido decremento nel cambio di destinazione d’uso di un suolo (da forestale/boschivo a coltivato). Tuttavia, la biodiversità agricola, legata alla diversificazione delle specie viventi adatte alla vita in un ambiente “antropizzato”, dipende fortemente dal tipo di tecniche agricole utilizzate [8-11]. Infatti le pratiche intensive (intese come quelle che non guardano alla salvaguardia dell’ambiente ma solo alla produttività economica) portano ad una riduzione della biodiversità che è dal 10 al 30 % in meno rispetto a quella che si misura quando si fa uso di pratiche sostenibili [8-11]. Dal momento che è stato evidenziato che la salubrità alimentare è direttamente correlata alla biodiversità agricola [12, 13], da qualche anno tutte le agenzie internazionali spingono per l’applicazione di pratiche agricole sostenibili [12-14]. Queste ultime, quindi, oltre a consentire la conservazione delle risorse non rinnovabili come definite in precedenza, consentono anche la salvaguardia della biodiversità. Quest’ultima può essere a tutti gli effetti considerata anch’essa come una risorsa non rinnovabile (esattamente come suolo, aria ed acqua) da proteggere e conservare per il miglioramento della qualità della vita umana.

COSA SONO GLI ORGANISMI GENETICAMENTE MODIFICATI O OGM?

Esistono due aspetti distinti che devono essere presi in considerazione per definire il significato di “organismo geneticamente modificato”. Da un lato abbiamo l’approccio scientifico che si basa sui fatti, dall’altro abbiamo l’approccio politico che non tiene conto dei fatti ma solo dell’umore degli elettori e delle convenienze elettorali. Insomma, l’approccio politico alla definizione di OGM è di carattere culturale, piuttosto che reale [15]. Ma andiamo con ordine.

LE MODIFICHE GENETICHE PER LA SCIENZA

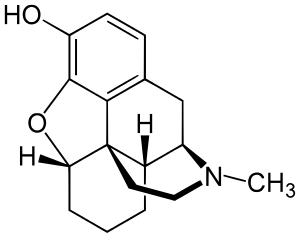

Fin da quando Darwin ha posto le basi della teoria dell’evoluzione è apparso chiaro, ed è diventato progressivamente sempre più evidente sotto il profilo sperimentale, che tutti gli organismi viventi hanno avuto origine da un progenitore comune che oggi noi chiamiamo LUCA, ovvero “Last universal common ancestor”, che altro non è che il famoso brodo primordiale nel quale si sono realizzate tutte le condizioni chimico fisiche per la formazione delle protocellule e lo sviluppo del metabolismo che caratterizza tutti gli esseri viventi [16]. Solo l’evoluzione, associata all’adattamento alle condizioni ambientali, dal progenitore comune riesce a spiegare la similitudine tra il nostro patrimonio genetico e quello di tanti altri organismi viventi. Per esempio, oltre il 98% di similitudine esiste tra il DNA umano e quello degli scimpanzé, oltre il 90% di affinità esiste tra il DNA umano e quello dei topi mentre oltre il 50% di somiglianza accomuna il nostro DNA a quello delle piante [15].

La differenziazione genetica avviene in modo casuale per effetto di errori imprevedibili durante i processi di replicazione del DNA. La moltitudine di organismi che viene così generata (quella che in precedenza è stata identificata col termine di “biodiversità”) è fatta da individui che sotto la spinta della pressione ambientale possono soccombere oppure sopravvivere. In quest’ultimo caso, il patrimonio genetico viene trasmesso alle generazioni successive.

Nel corso di milioni di anni, la differenziazione genetica ha prodotto l’insieme di organismi viventi (dai microorganismi all’uomo) che oggi siamo abituati a conoscere. In definitiva, tutti noi siamo il prodotto di modificazioni genetiche (ovvero alterazioni imprevedibili del DNA) che ci consentono di occupare delle ben precise nicchie ecologiche nelle quali siamo in grado di sopravvivere [17].

Le modifiche genetiche possono essere indotte anche in modo mirato. Per esempio, fin da quando 10.000 anni fa l’uomo è passato dalla fase nomade di caccia/raccolta a quella stanziale di carattere prevalentemente agricolo [18], ha tentato, tra successi ed insuccessi, di modificare le caratteristiche genetiche dei vegetali e degli animali in modo da aumentare la produttività agricola dei primi e rendere più docili i secondi. In tutti e due i casi, lo scopo è sempre stata la massimizzazione della produzione alimentare così da sfamare un numero sempre più ampio (attualmente in fase di crescita esponenziale) di esseri umani.

In assenza di conoscenze specifiche, le modifiche genetiche mirate venivano indotte per tentativi ed errori attraverso l’incrocio di organismi aventi ognuno una o più delle caratteristiche desiderate. In questo modo era possibile ottenere piante “domestiche” in grado di resistere a certe particolari patologie a cui non erano soggette piante selvatiche e meno utili sotto l’aspetto alimentare. Allo stesso modo, era possibile selezionare animali da latte in grado di produrre questo alimento in modo continuativo o animali da caccia con specifiche caratteristiche morfologiche tali da renderli adatti per le diverse tipologie di caccia.

La progressione delle conoscenze ha condotto alla comprensione dei meccanismi biochimici alla base dell’ereditarietà genetica cosicché oggi è possibile operare modifiche genetiche con una possibilità di errore di gran lunga inferiore rispetto a quella associata ai tentativi di incrocio delle vecchie pratiche agricole/zootecniche. La nuove tecniche di ingegneria genetica consentono, infatti, di modificare il DNA di una specie vegetale variando unicamente i geni responsabili di certe particolari caratteristiche [19]. In questo modo si ottengono, in tempi molto più rapidi rispetto alle pratiche convenzionali, piante con proprietà nutrizionali o meccanismi di difesa di gran lunga superiori rispetto a quelle cosiddette tradizionali [15]. Un esempio tra tutti è il famoso “goldenrice” [20]. Si tratta di un riso modificato geneticamente capace di produrre, come metabolita secondario, il b-carotene, ovvero il precursore della vitamina A la cui carenza è associata a inibizione della crescita, deformazione e fragilità delle ossa e modifiche delle strutture epiteliali e degli organi riproduttivi [21]. La carenza di vitamina A si ottiene solo per deficit nutrizionali in quelle popolazioni che non hanno accesso a fonti alimentari in grado di fornire i precursori della suddetta vitamina. È il caso, per esempio, delle popolazioni orientali (India in testa) la cui alimentazione è prevalentemente basata sull’uso del riso. La sostituzione del riso tradizionale col riso golden consente di superare i problemi nutrizionali di cui si accennava.

LE MODIFICHE GENETICHE PER LA POLITICA E L’OPINIONE COMUNE

È stato evidenziato come, sotto l’aspetto scientifico, tutti gli esseri viventi possano essere considerati come organismi geneticamente modificati perché derivati da processi evolutivi durante i quali piccole variazioni genetiche hanno consentito l’adattamento (e, di conseguenza, la sopravvivenza) nelle condizioni più disparate. È stato anche puntualizzato come il progresso tecnologico in ambito agricolo consenta oggi di effettuare modifiche genetiche mirate ed in tempi brevi in modo da ottimizzare la produttività agricola. I prodotti agricoli selezionati mediante ingegneria genetica non vengono utilizzati o immessi in commercio a cuor leggero, ma subiscono una serie di controlli molto minuziosi in modo da rilevare ogni possibile effetto collaterale sulla salute umana [15]. Nonostante la “naturalità” (nel senso comune del termine) delle modifiche genetiche e gli innumerevoli controlli cui i prodotti modificati geneticamente sono sottoposti, la politica, che – come già evidenziato – segue gli umori degli elettori, cerca di opporsi in tutti i modi agli OGM.

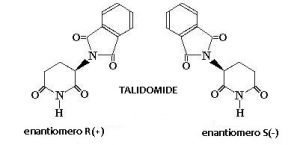

La prima direttiva Europea 90/220/CEE sugli OGM stabilisce al comma 2 dell’articolo 2 che è “organismo geneticamente modificato (OGM), un organismo il cui materiale genetico è stato modificato in modo diverso da quanto si verifica in natura con l’accoppiamento e/o la ricombinazione genetica naturale” [22], laddove viene preso in considerazione il concetto di “natura” che, come evidenziato in molta letteratura, è solo ed esclusivamente di carattere culturale [15, 23]. I processi tecnologici mirati alle modifiche genetiche per il miglioramento delle caratteristiche vegetali sono in tutto e per tutto simili, in termini biochimici, a quanto accade “naturalmente”. La differenza che una certa politica vuole vedere è solo nel procedimento utilizzato. In questo modo una modifica genetica ottenuta per tentativi ed errori mediante innesti non porta, normativamente, ad un OGM, mentre un organismo ottenuto mediante la tecnica del DNA ricombinante è considerato, per legge, un OGM. Si deve, quindi, puntualizzare che, sotto l’aspetto scientifico, questa differenziazione normativa è completamente priva di significato e potrebbe essere legata unicamente ad una politica protezionistica delle aziende di prodotti fitosanitari di cui il vecchio continente, e l’Italia in particolare, è abbastanza ricco [15, 24, 25]. In effetti, come riportato in una intervista alla senatrice Elena Cattaneo su Linkiesta [24], i maggiori avversari, in Italia, dei prodotti OGM sono proprio le aziende che producono fitofarmaci [25] le quali vedrebbero ridurre i propri introiti dalla introduzione in agricoltura delle piante OGM (nel prossimo paragrafo si discuterà brevemente dei possibili vantaggi/svantaggi dell’uso agricolo degli OGM).

Ma quale è il ruolo giocato dalle popolazioni Europee nell’indirizzare la politica dell’Unione e degli stati membri? In realtà bisogna dire che i cittadini dell’Unione Europea non sono adeguatamente informati sull’aspetto scientifico degli OGM e risentono in gran parte delle leggende e dei miti propagandati ad arte da gente di spettacolo [26] e da persone che hanno mitizzato i sapori delle epoche andate [27]. Tra questi miti sono da ricordare quello delle biotecnologie contro natura, della alterazione del DNA umano per ingestione di piante OGM, della diffusione della resistenza agli antibiotici con conseguente incremento nella difficoltà a resistere ad alcune malattie, della riduzione della biodiversità (di cui si discuterà più avanti) e così via cantando [28]. La scarsa preparazione scientifica associata ai miti anzidetti fa in modo che il cittadino EU prema sui governi affinché venga limitato l’uso di organismi geneticamente modificati in agricoltura. I governi colgono la palla al balzo e, per non perdere consensi, seguono l’umore del “popolo” abusando di un principio di precauzione che, come si intuisce da quanto scritto fino ad ora e come si comprenderà dalla lettura dei paragrafi seguenti, non ha alcun senso.

AGRICOLTURA ED OGM

Al momento attuale l’uso di organismi geneticamente modificati in agricoltura è vietato in quasi tutta Europa. Solo Spagna e Portogallo hanno introdotto coltivazioni di mais OGM [29]. Tuttavia, la ascientificità delle proibizioni normative in atto sia in Europa che in tantissimi paesi del globo terrestre è supportata dalla pubblicazione di numerosi studi che evidenziano l’efficacia economica ed ambientale nell’uso agricolo di piante geneticamente modificate. In Cina, per esempio, la coltivazione di cotone OGM (quello che viene indicato come cotone Bt, ovvero modificato geneticamente con il gene del Bacillusthuringensis inserito nel vegetale per fargli produrre una tossina che lo rende resistente ai parassiti) ha portato benefici sia economici che ambientali. Infatti, studi condotti per la valutazione a breve [30] e lungo termine [31] del cotone Bt sulla società Cinese dimostrano non solo che gli agricoltori che hanno introdotto questa pianta nella loro produzione hanno avuto un incremento di guadagni economici, ma hanno anche operato una riduzione nella quantità di fitofarmaci, dannosi per l’ambiente, usati nella loro pratica agricola. Il cotone Bt ha apportato benefici anche agli agricoltori Indiani come riportato nei riferimenti [32-34]. Inoltre, impatti positivi, sia economici che ambientali, si sono avuti anche in alcuni paesi del Sud America (Brasile, Argentina e Paraguay) e negli Stati Uniti [35-37] a seguito dell’introduzione della soja OGM.

Nonostante la grande massa di dati sperimentali che attestano della positività dell’uso in agricoltura di piante OGM, un lavoro molto recente pubblicato su Science Advances [38] si pone in controtendenza rispetto a quanto finora riportato per gli Stati Uniti. In particolare, gli autori dello studio [38] rivelano che mentre l’uso di mais OGM ha portato ad una riduzione della quantità di insetticidi ed erbicidi rispetto alla situazione antecedente al 1998, l’uso di soja OGM ha comportato sì una riduzione nella quantità di insetticidi, ma un incremento in quella di erbicidi. Gli autori del lavoro contestualizzano i loro dati evidenziando che l’incremento nell’uso di erbicidi conseguente alla coltivazione di soja OGM è dovuto all’aumento alla resistenza al glifosato [39] da parte delle erbe infestanti.

RELAZIONE TRA ORGANISMI GENETICAMENTE MODIFICATI E BIODIVERSITA’

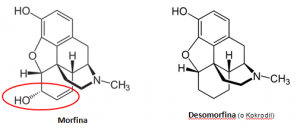

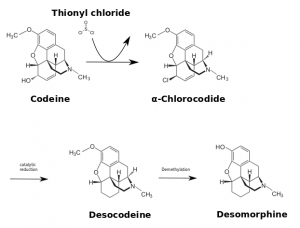

La nota in merito all’aumento alla resistenza al glifosato da parte delle erbe infestanti riportata nel riferimento [38] è un interessante punto di partenza per discutere dell’argomento OGM-biodiversità, scopo del presente articolo. Infatti, il punto focale del predetto studio [38] è che l’aumento della resistenza al glifosato da parte delle erbe infestanti è conseguente alla coltivazione di soja Roundup® resistant. Il Roundup® è un fitofarmaco a base di glifosato [39]. La soja Roundup® resistant è un vegetale che non subisce danni da parte del glifosato. Nel momento in cui la soja Roundup® resistant viene coltivata, si può far gran uso di glifosato per eliminare le erbe infestanti che competono con la soja per l’assunzione di nutrienti dal suolo. La velocità di riproduzione e crescita delle erbe infestanti consente una variabilità genetica molto elevata. Questo significa che, per effetto degli errori casuali nella replicazione del DNA di cui si accennava in precedenza, è possibile che, tra le tante piantine infestanti, ne possa nascere qualcuna che sia resistente al glifosato. La conseguenza è che sono proprio queste ultime, più adatte a sopravvivere al citato erbicida, a prendere il sopravvento e a portare ad un uso sempre più massiccio di glifosato o di altre tipologie di erbicidi. In altre parole, la coltivazione della soja Roundup® resistant favorisce la biodiversità. Si tratta di un tipo di biodiversità economicamente dannosa e contro la quale bisogna applicare fitofarmaci dal forte impatto ambientale; ma il punto, per il momento, non è questo. Il punto è che l’uso di un sistema OGM favorisce la biodiversità vegetale strettamente detta. Una situazione analoga, sebbene più utile sotto l’aspetto economico per gli agricoltori che decidono di farne uso, si verifica in tutti quei paesi in cui non sono validi i brevetti sulle piante OGM. Per esempio in India il cotone Bt prodotto dalla Monsanto è stato utilizzato per generare 137 differenti ibridi ognuno con proprietà ben specifiche [15]. La possibilità di avere un numero di specie vegetali potenzialmente infinito mediante l’uso dell’ingegneria genetica ha consentito di salvaguardare tanti prodotti tipici [15] come, per esempio, la papaya nelle Hawaii [40] o il pomodoro San Marzano [41] prodotto tipico Campano. In altre parole, sulla base delle definizioni oggettive date in merito a biodiversità e sistemi OGM, si può concludere che gli organismi geneticamente modificati possono essere considerati come risorsa per la biodiversità, piuttosto che come un problema come da più parti propagandato [42-44].

CONCLUSIONI

Gli organismi geneticamente modificati sono una risorsa per la biodiversità. Tuttavia, bisogna evidenziare che oltre ad una biodiversità economicamente conveniente, l’uso di coltivazioni OGM può generare una biodiversità vegetale contrastabile attraverso un uso progressivamente più massiccio di fitofarmaci potenzialmente dannosi per l’ambiente. Alla luce di questo, gli OGM devono essere condannati senza appello? La risposta è: certamente no. L’applicazione dell’ingegneria genetica all’agricoltura si inserisce nell’ambito di quella che è stata dichiarata in precedenza come “agricoltura sostenibile”. In altre parole, gli OGM devono essere pensati come complementari ai prodotti dell’agricoltura tradizionale (intensiva o meno) in modo da consentire la salvaguardia sia dei prodotti tipici che di tutte le risorse ambientali non rinnovabili dalla cui “distruzione”, alla luce dei meccanismi che avvengono in natura, gli unici ad uscire sconfitti sono solo gli esseri umani.

RIFERIMENTI

1

https://www.crcpress.com/Environmental-Chemistry-Ninth-Edition/Manahan- Manahan/p/book/9781420059205

2

https://www.researchgate.net/publication/279179431_Research_and_Application_of_Biochar_in_Europe

3

http://www.sinanet.isprambiente.it/gelso/tematiche/buone-pratiche-per-lagricoltura

4

http://sito.entecra.it/portale/public/documenti/Risultati/445a78ed-4c43-1944-62b0-4ee61d1615a1.pdf

5

http://dspace.inea.it/bitstream/inea/519/1/Agres_Metodi.pdf

6

http://www.isprambiente.gov.it/it/temi/biodiversita

7

http://www.bollatiboringhieri.it/scheda.php?codice=9788833927039

8

http://onlinelibrary.wiley.com/doi/10.1111/gcb.12517/full

9

http://link.springer.com/article/10.1007/s10460-009-9251-4

10

http://www.nature.com/articles/ncomms5151

11

http://onlinelibrary.wiley.com/doi/10.1111/1365-2664.12219/full

12

http://www.fao.org/docrep/006/y5418i/y5418i00.HTM

13

http://ec.europa.eu/agriculture/cap-post-2013/communication/com2010-672_it.pdf

14

http://www1.interno.gov.it/mininterno/export/sites/default/it/sezioni/sala_stampa/notizie/formazione_professionale/app_notizia_20084.html

15

Dario Bressanini, OGM tra leggende e realtà, Zanichelli, 2009 (http://online.scuola.zanichelli.it/chiavidilettura/ogm-tra-leggende-e-realta/)

16

Cristian De Duve, Alle origini della vita, Bollati Boringheri, 2011 (http://www.bollatiboringhieri.it/scheda.php?codice=9788833922072)

17

http://online.scuola.zanichelli.it/LupiaSaraceni_ScienzeIntegrate-files/Zanichelli_Lupia_Saraceni_Scienze_Sintesi_UB1.pdf

18

http://www.laputa.it/libri/da-animali-a-dei-breve-storia-dellumanita/

19 http://nut.entecra.it/files/download/Pubblicazioni_divulgative/inran_interno_web_bassaqualita.pdf

20

http://www.treccani.it/enciclopedia/golden-rice_(Enciclopedia-della-Scienza-e-della-Tecnica)/

21

http://www.msd-italia.it/altre/manuale/sez01/0030035.html

22

http://eur-lex.europa.eu/legal-content/IT/TXT/PDF/?uri=CELEX:31990L0220&from=IT

23

Silvano Fuso, Naturale = Buono, Carocci editore, 2016 (http://www.carocci.it/index.php?option=com_carocci&task=schedalibro&Itemid=72&isbn=9788843079230)

24

http://www.linkiesta.it/it/article/2015/10/11/perche-gli-ogm-fanno-paura/27729/

25

http://www.prodottifitosanitari.net/imprese/elenco_imprese

26

http://www.beppegrillo.it/2013/07/passaparola_ogm_tolleranza_zero.html

27

http://www.slowfood.com/sloweurope/it/gli-ogm-in-europa/

28

http://www.siga.unina.it/circolari/Fascicolo_OGM.pdf

29

http://www.greenbiz.it/food/agricoltura/12679-ogm-2014

30

Pray & Ma, 2001, Impact of BT cotton in China, World Development, 29: 813-825 (http://www.sciencedirect.com/science/article/pii/S0305750X01000109)

31

Qiao, 2015, Fifteen Years of Bt Cotton in China: The Economic Impact and its Dynamics, World Development, 70: 177-185 (http://www.sciencedirect.com/science/article/pii/S0305750X15000121)

32

Qaim, 2003, Bt Cotton in India: Field Trial Results and Economic Projections, World Development, 31: 2115–2127 (http://www.sciencedirect.com/science/article/pii/S0305750X03001670)

33

Krishna &Qaim, 2012, Bt cotton and sustainability of pesticide reduction in India, Agricultural Systems, 107: 47-55 (http://www.sciencedirect.com/science/article/pii/S0308521X11001764)

34

Subramanian &Qaim, 2009, Village-wide effects of agricultural biotechnology: the case of Bt cotton in India, World Development, 37: 256-267 (http://www.sciencedirect.com/science/article/pii/S0305750X0800123X)

35

https://www.researchgate.net/profile/Clemens_Van_de_Wiel/publication/242115382_GM-related_sustainability_agro-ecological_impacts_risks_and_opportunities_of_soy_production_in_Argentina_and_Brazil/links/554725d30cf234bdb21db793.pdf

36

http://www.agbioforum.org/v8n23/v8n23a15-brookes.htm?&sa=U&ei=KojTVOKAL9CyogTSqYCgCg&ved=0CBQQFjAA&usg=AFQjCNH-zn1ERidarL6-x-Pnq3lsHjPUeg

37

Bonny, 2008, Genetically modified glyphosate-tolerant soybean in the USA: adoption factors, impacts and prospects. A review, Agronomy for Sustainable Development, 28: 21-32 (http://link.springer.com/article/10.1051/agro:2007044)

38

Perry & al., 2016, Genetically engineered crops and pesticide use in U.S. maize and soybeans, Science Advances,

2(8), e1600850 (http://advances.sciencemag.org/content/2/8/e1600850.full.pdf+html)

39

http://www.laputa.it/blog/glifosato-pericolo-ambiente-innocuo-uomo/

40

http://www.gmo-compass.org/eng/grocery_shopping/fruit_vegetables/14.genetically_modified_papayas_virus_resistance.html

41

http://www.ncfap.org/documents/VirusResistantTomato.pdf

42

Facciamo chiarezza

43

http://cmsdata.iucn.org/downloads/ip_gmo_09_2007_1_.pdf

44

http://agroeco.org/wp-content/uploads/2010/09/garcia-altieri.pdf

Fonte dell’immagine di copertina: Wikimedia Commons